利用 AnythingLLM 构建自己的私人 ChatGPT

小鱼发表于 2024-06-10 10:05:05

AnythingLLM是一个全栈应用,可以使用现有的商业化LLM(大型语言模型)或者流行的开源LLM和向量数据库方案,来建立一个没有妥协的私人ChatGPT,既能在本地运行,也能远程托管,能和您提供的任何文件智能对话。

AnythingLLM把您的文件分成了叫作工作区的东西。工作区的作用有点像线程,但是你的文件都被容器化了。工作区间可以分享文件,但他们不互相交流,这样可以让每个工作区的环境都很清爽。

AnythingLLM的一些有趣特性:

- 支持多用户和权限设置

- 支持多种文件类型(如PDF、TXT、DOCX等)通过简洁的用户界面管理向量数据库中的文件

- 两种聊天模式:会话模式和查询模式。会话模式会保存之前的问题和更正;查询模式则是针对文件的基本问答。在聊天中加入引用链接至原文档源和文字

- 方便快速迭代的技术栈

- 云端部署准备就绪

- “自己带LLM”的模式

- 非常有效的成本节约措施,对于处理庞大的文件来说特别划算。您永远不会因为多次嵌入大文件或转录文件而支付额外费用。相比于其他文件聊天机器人的解决方案,它提供了高达90%的成本效益提升。

- 提供完全的开发者API以实现自定义集成!

Github地址:https://github.com/Mintplex-Labs/anything-llmgithub.com/Mintplex-Labs/anything-llm

本地部署

llama.cpp server

提供兼容Openai 的 API,为anythingLLM提供运行后端

/data/llama.cpp/server -m qwen/qwen72b-chat-q4_0.gguf -ngl 100 --host 0.0.0.0 -c 2048anythingLLM

docker 启动

官方文档:

本地简单临时启用,无数据持久化

docker run -d -p3001:3001 mintplexlabs/anythingllm:master界面配置

访问 http://<yourip>:3001

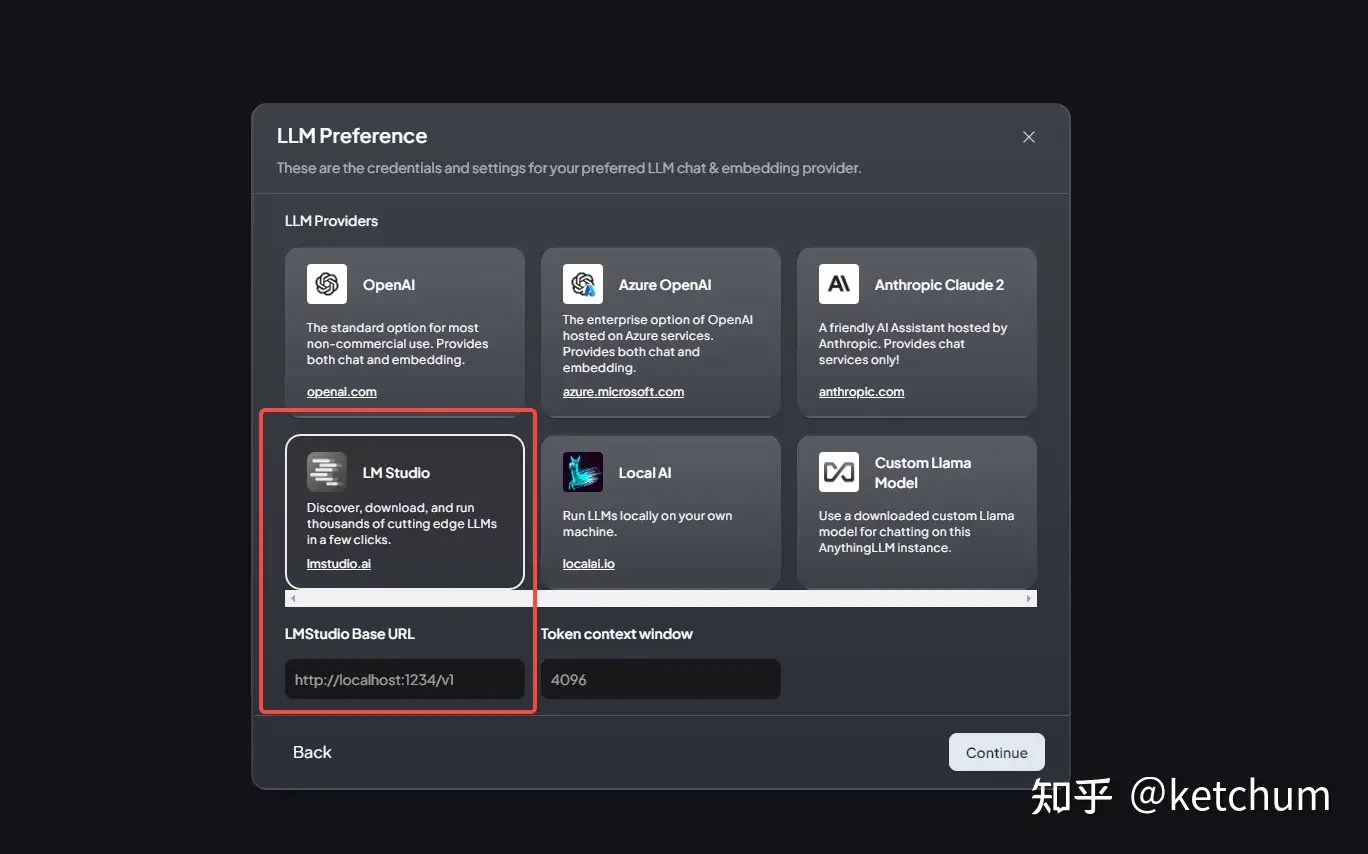

选择LM Studio 配置base url

http://<yourip>:8080/v1

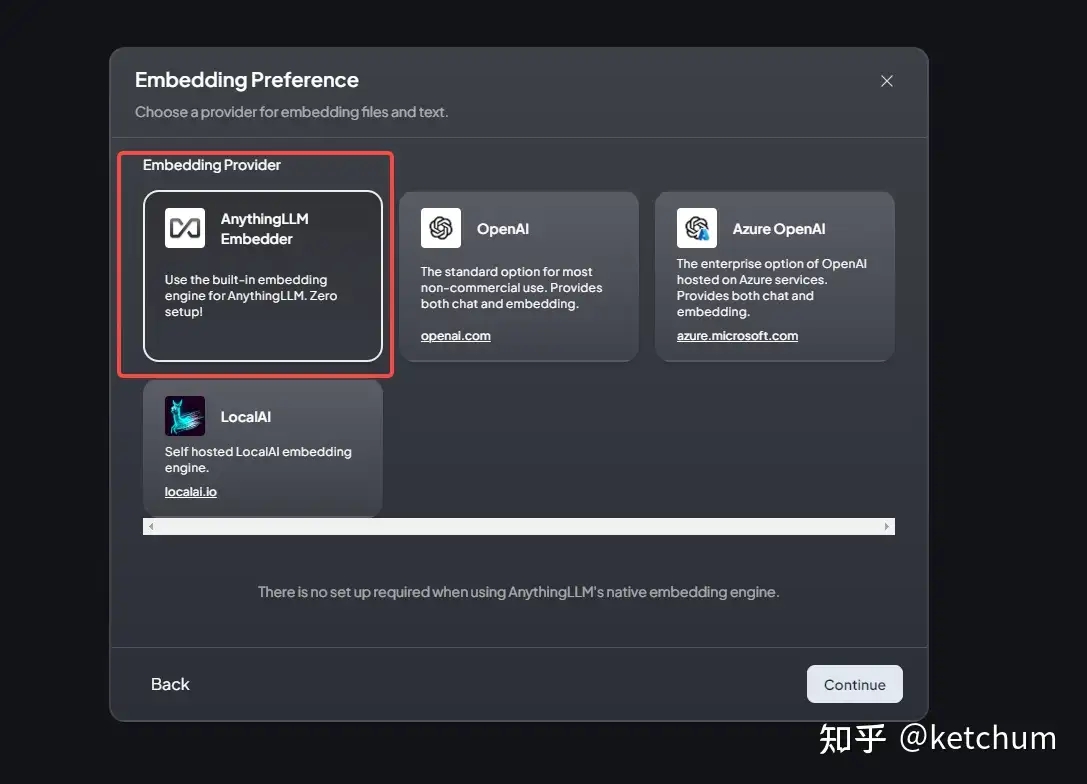

embedding 选择 第一个

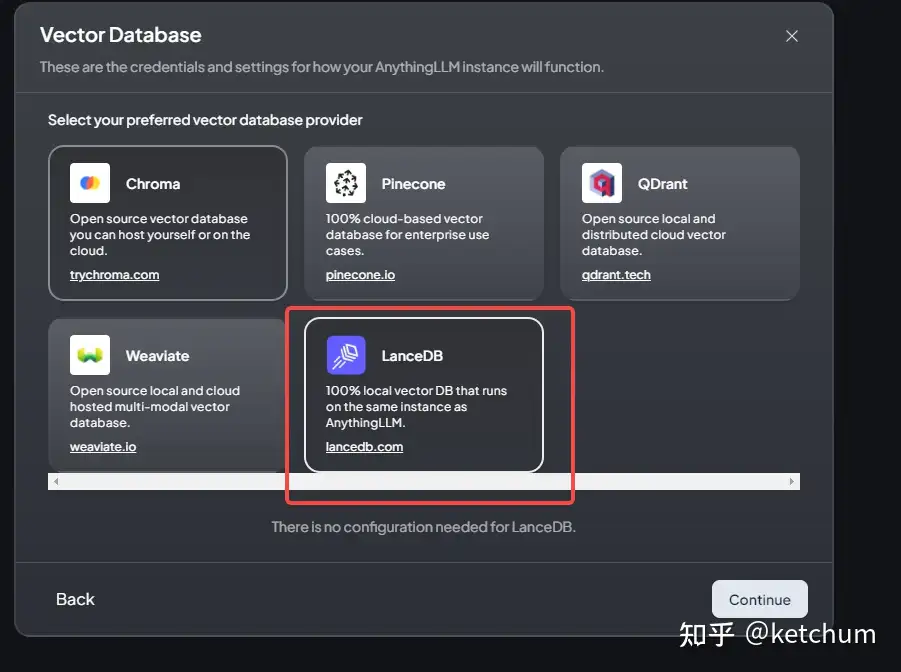

向量数据库选择最后一个

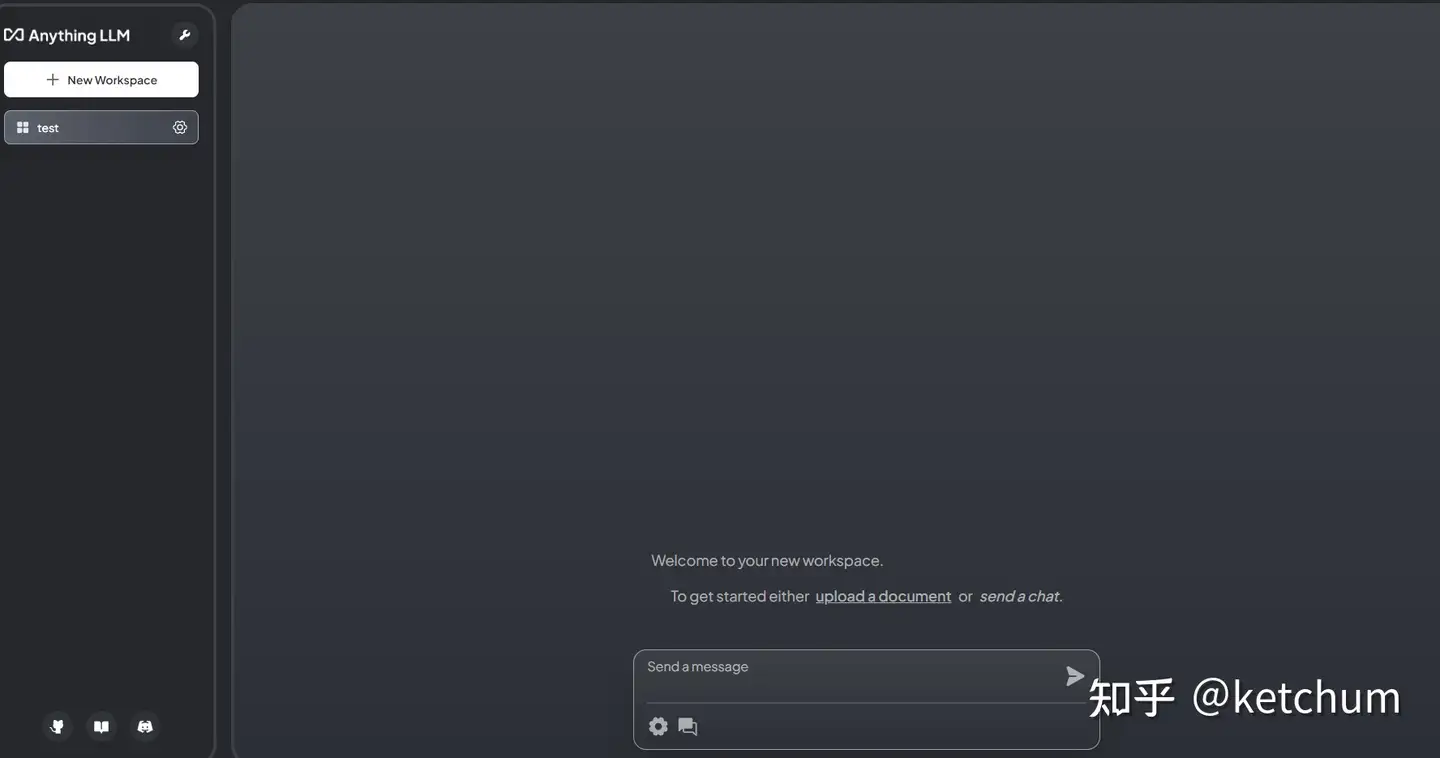

最终配置后的界面如下:

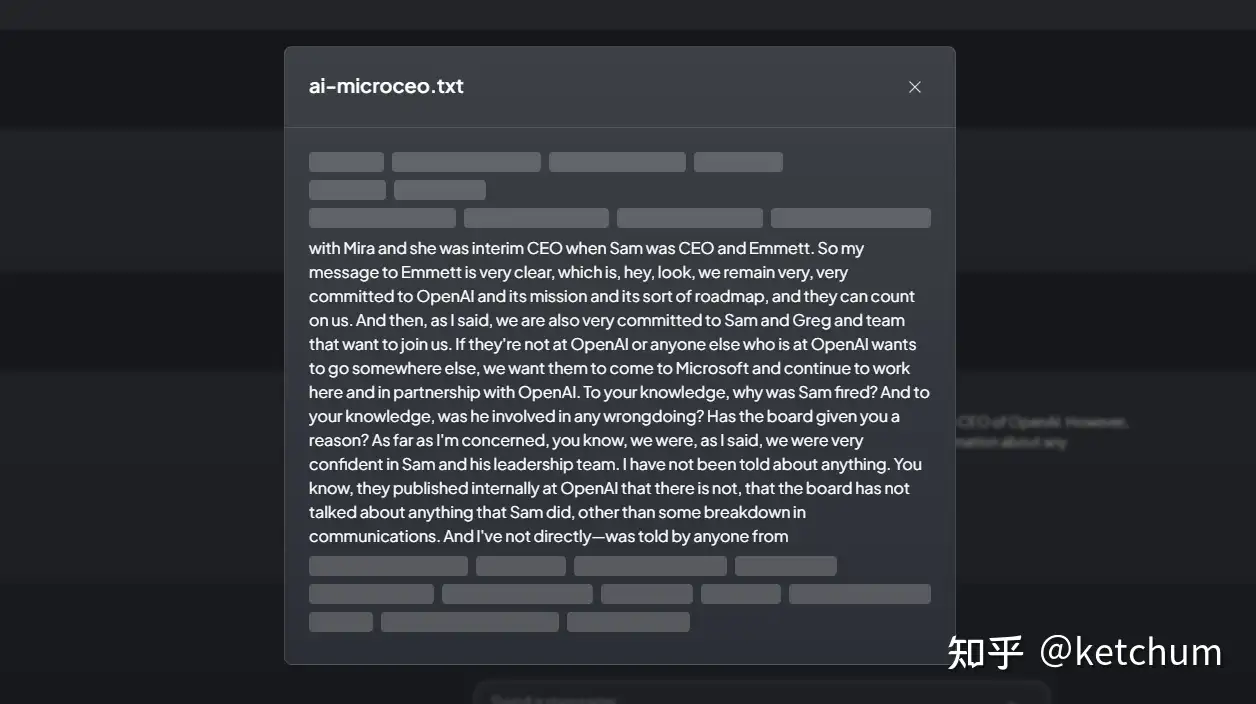

使用展示

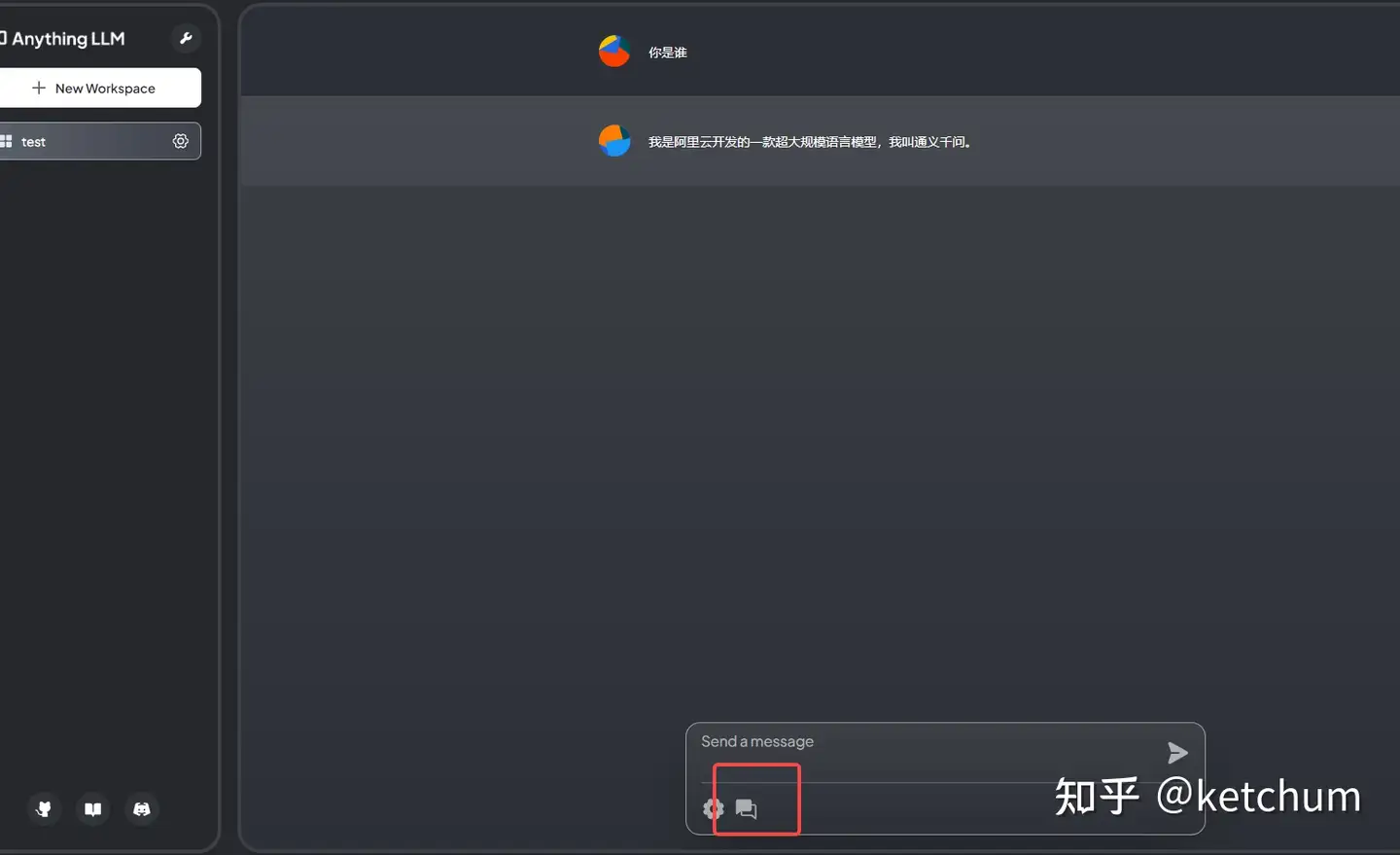

chat模式

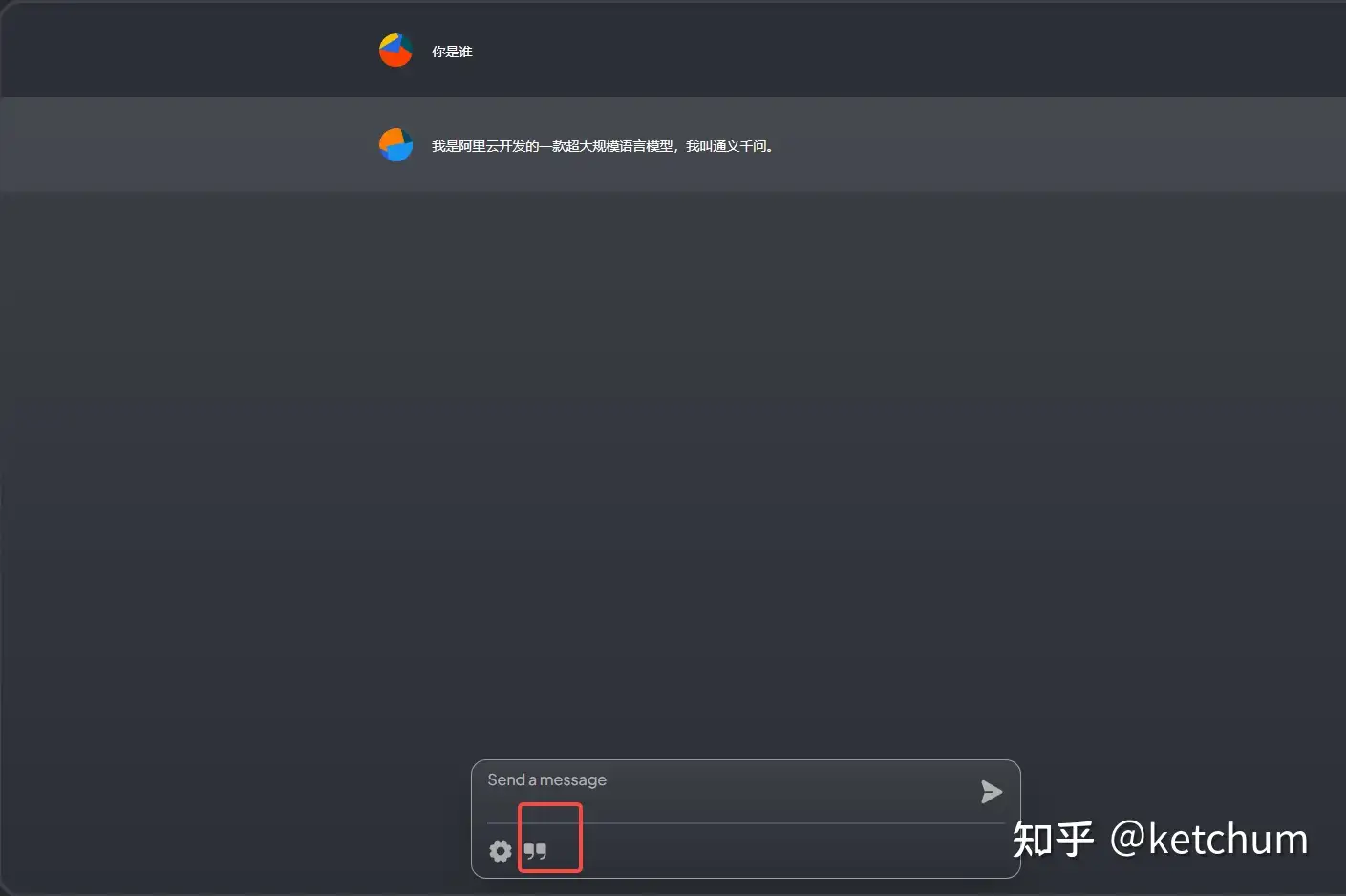

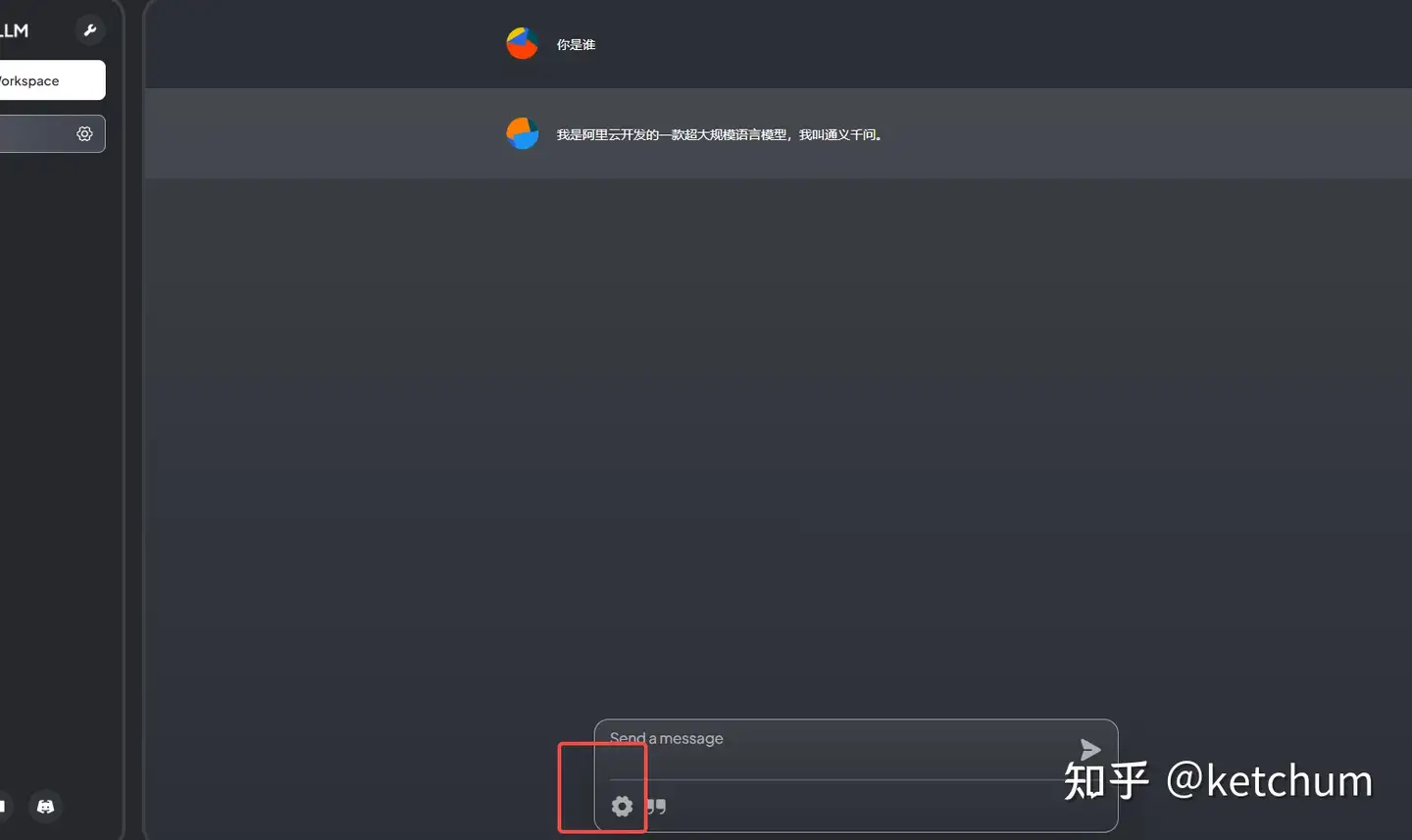

文档问答模式

点击上图红色标记处位置切换为文档问答模式

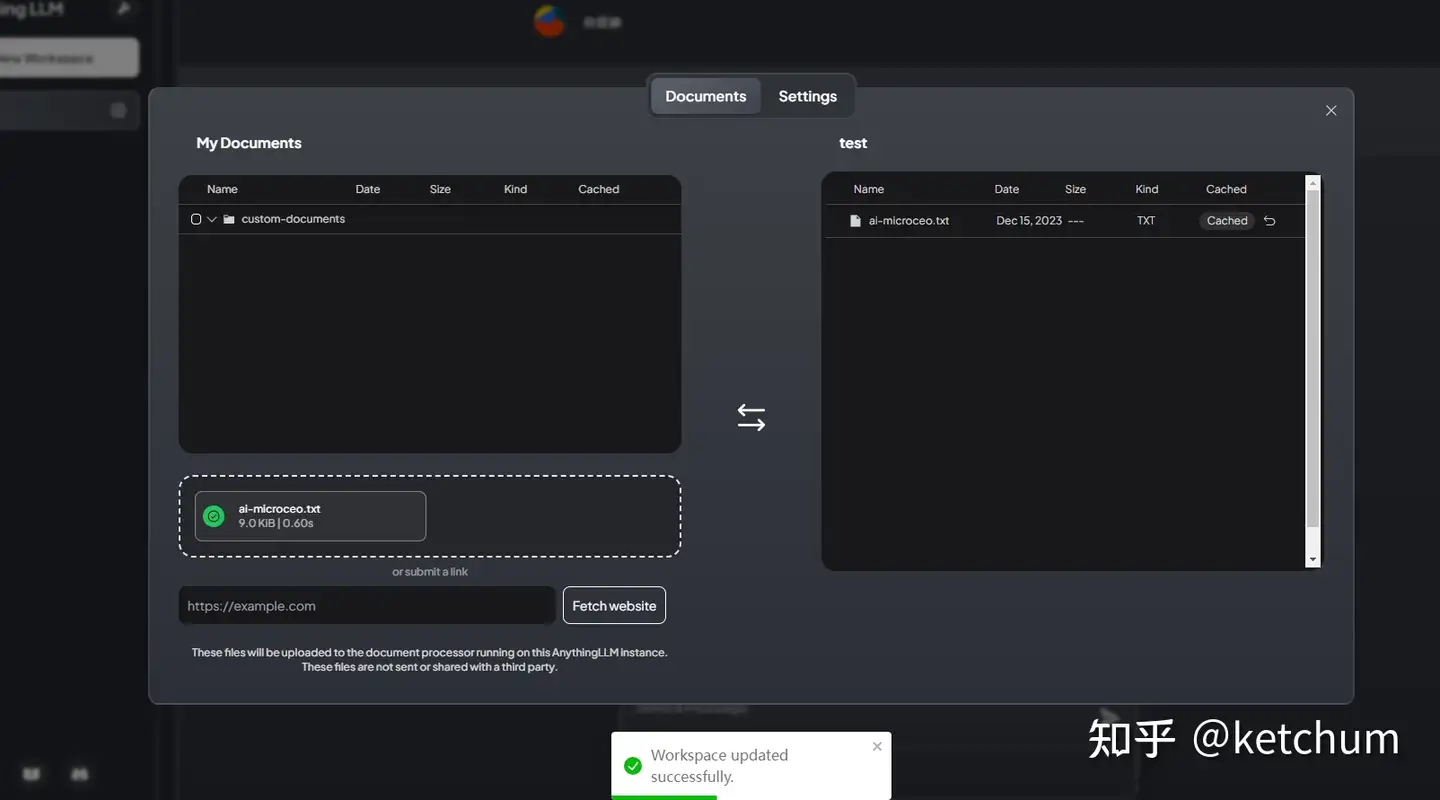

点击设置按钮,上传文档

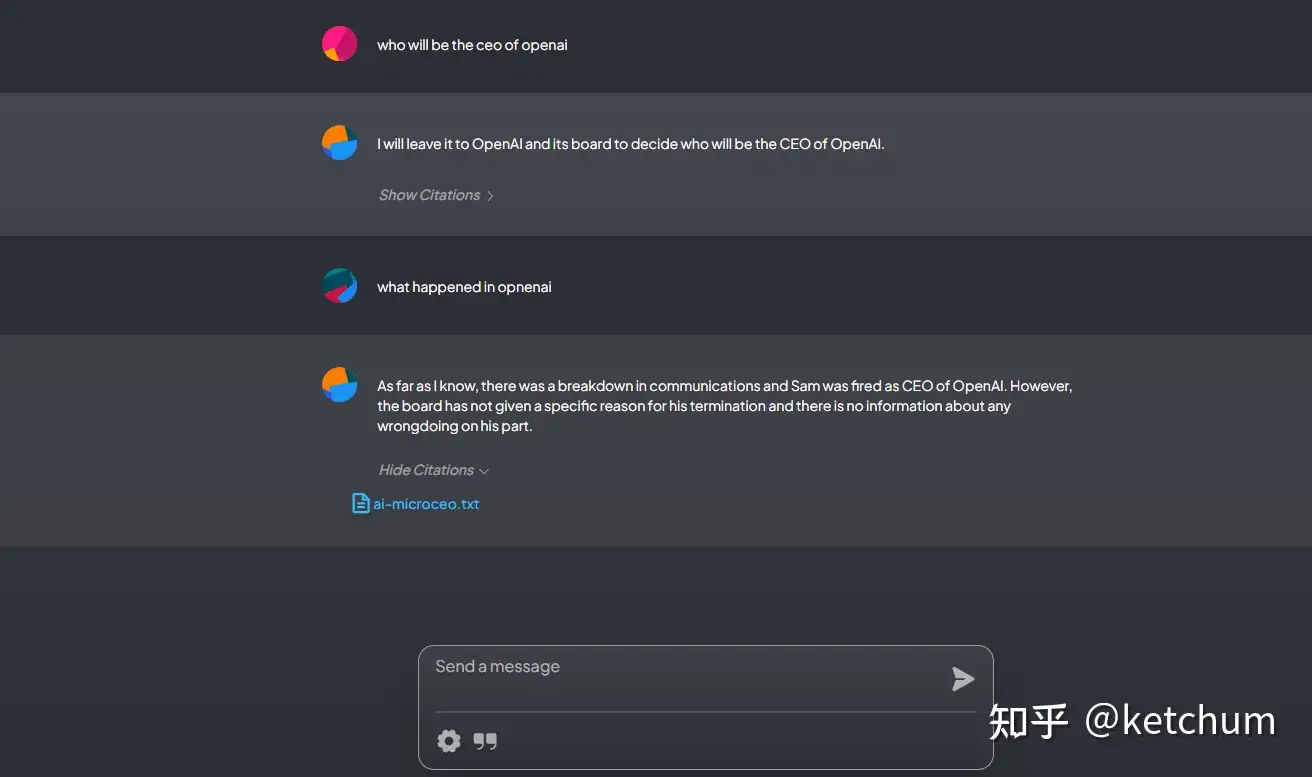

返回主界面进行文档问答

问答模式下,会显示该回答所引用的原文,方便查看确认信息