雷达和摄像头遍布全车,为什么自动驾驶依然是期货?

之前参加一个汽车评测活动,中间有个智能泊车的项目,其中分三项:侧方位停车、垂直车位停车,斜方位停车,来测评现阶段主流新能源车型的智能泊车水准。

这次测评所设置的车位并不宽裕,相对于普通车位来说狭窄一些,但我觉得难度应该不大,因为是低速状态,且周边环境并不复杂,地面标识线非常清晰,天气状况良好,所以感觉是不大可能难得住这些参赛车型的,顶多是用时长短罢了。

但在”侧方位停车、垂直车位停车”这些科二必考的项目,参赛的车型都完成得很好。但到了“斜方位停车”这一项上面,好几个车型都犯了迷糊。

(下面描述只是某些场景的节选,用于举例,并无具体品牌的正负面宣传!)

比如北汽极狐阿尔法过去,又回来,又过去,弄了两三趟,就是识别不出来中间的那个车位。

最后,识别出来了中间的车位,结果在倒到了一半的时候,智能泊车自行退出,需要人工进行接管。

而对于斜方位停车,小鹏的P7i也是有些摸不着头脑,两次尝试都没识别出来正确的车位,停错了车位。直到第三次尝试才成功。

而6月底开始交付的问界M5智驾版的算法应该比较新,一次性找准了车位,稳稳地停了进去。

这里并不是说问界就比小鹏智能辅助强,在后续一系列的测试中,两者在智能辅助驾驶上面实际都非常优秀。

但两者硬件配置实际可以对比下。

问界M5 2023增程后驱智驾版和小鹏P7i Max性能版。

小鹏和问界的外部摄像头均是11个,超声波雷达均是12个,前四后四左二右二。毫米波雷达小鹏是5个,分布在车前后和侧面,问界是3个,一前两后。激光雷达问界是1个,在头顶中央。小鹏是两个,在左右大灯处,小鹏激光雷达的线束也比问界多。

按道理说,问界在对外感知探测的硬件设备上,是不如小鹏的,且小鹏P7i搭载的智能辅助芯片是双Orin-X,算力是508TOPS。

但除了硬件感知之外,关于智能辅助的算法也很重要,也就是自动驾驶的第二个模块。

自动驾驶的三个核心模块:感知———思考———行动

感知:

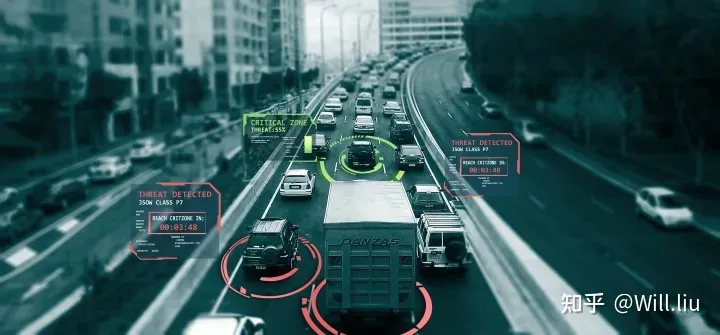

利用各类传感器,如摄像头、雷达、超声波来感知和认识周围的环境。通常需要360°的全环境视图和高精地图配合GPS等来进行精准的定位,并能够检测驾驶员能否有能力控制车辆。

思考:

通过车辆计算机的软件和智能算法执行,处理和解释感知得到的数据。整个过程必须要在非常短的时间内完成,因为如果时速120公里/小时,一秒的时间就足够车辆窜三十几米远了。所以,得要求车辆电脑在毫秒级别就要思考完毕,并得出可靠的预测,规划下一步合适的驾驶策略。

行动:

考虑到周围环境的所有感知数据和定位,能独立、快速、安全、精确地使用动力系统、转向系统和制动系统来移动车辆,使得思考的驾驶策略付诸实践。

所以,如果专门训练过算法斜方位停车的各种内容,即便硬件不是顶尖,一样可以完成得快准好。

但是要算法能够覆盖到所有用车的场景,又是何其困难的事情。比如车辆的摄像头/毫米波雷达/激光雷达可以鉴别出前方有卡车。但如果卡车上装了一颗大树,因为无法理解这种大树的树冠在马路上移动的场景,算法就很难识别出来前面是啥。

而如果要穷极绝大部分Corner Case来保障自动驾驶算法的识别精准度,让自动驾驶的识别能力能够完全替代人类的识别能力,对于现阶段来说,依旧是一个天大的难题。

而以上只是难点之一,现在特斯拉走的纯视觉路线,只是单感知的算法,但依旧不完善,特斯拉数年来一直不断更新版本,才能覆盖更多使用场景,提高安全系数。

而如果不止一种感知途径,不止摄像头,还要加上超声波雷达、毫米波雷达,激光雷达等多感知融合,那么可想而知会更困难。这也是为什么,一大堆品牌堆算力,堆硬件感知设备,依旧在一些我们觉得很幼稚的场景上频频犯错的原因。

而不仅仅是软件的难题,实际现阶段的智能辅助驾驶的硬件部分也远远不能达到真正的自动驾驶要求。

之前说过,为什么要采纳多种感知设备,就是为了取长补短。

比如毫米波雷达,优点就是无视天气,穿透雾气、烟尘的能力强,受到环境因素影响较小,可以保障在日常情况下的使用。但缺点就是精度不高,对金属物敏感,容易对静态物品产生误判,且无法判断障碍物的垂直高度。

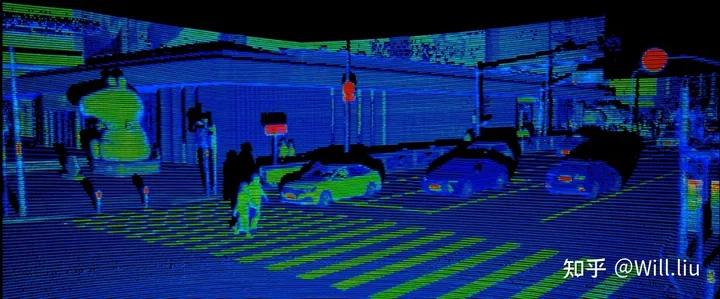

比如激光雷达的精度极高,近距离能达到毫米级别。且探测距离远,角分辨率超过毫米波雷达数个等级,轻松可以达到0.1°,功率足够的话,可以清晰分辨出一里开外的行人。激光雷达不仅可以分辨3D物体,还能利用回波强度形成的灰度图(交通涂层和混凝土/沥青/植被的回波强度值差别较大)分辨出地面标识,在摄像头无法捕捉地面标识清晰图像时(黑夜、地面有水),探知地面的交通标识。

但缺点就是激光雷达贵,容易受大雨大雾影响,光滑反光表面,强光源(如太阳)都会对激光雷达产生较强干扰,此外激光雷达的反馈信息十分复杂,对芯片的算力要求也非常高,间接提高了使用成本。

比如摄像头的优点就是在光线良好的情况下精度较高,能准确分辨平面图形和图案。但缺点也很明显,受光线、天气影响大,且难以分辨立体障碍物。

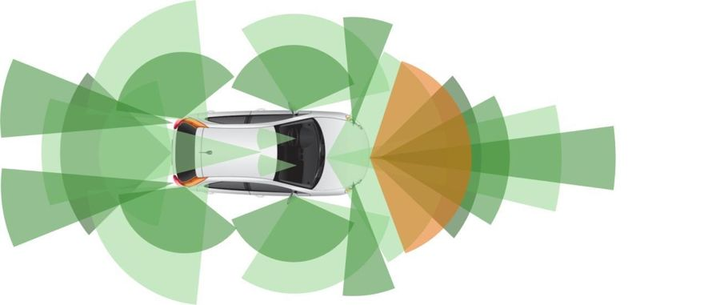

所以,一辆能够达到真正自动驾驶的车辆,是需要多个感知硬件的互补的。

比如遇到静态金属物体,毫米波雷达测不准的时候,摄像头未必受到影响。而在雨夜天气下,激光雷达受到影响了,摄像头拍摄不到清晰图片的时候,毫米波雷达却可以正常使用。这样外界干扰怎么剧烈,恶劣环境下总有一种感知硬件可以正常探知外界。

但是即便配齐了各种感知硬件,现阶段量产车上的雷达、摄像头的数量却还是不够。

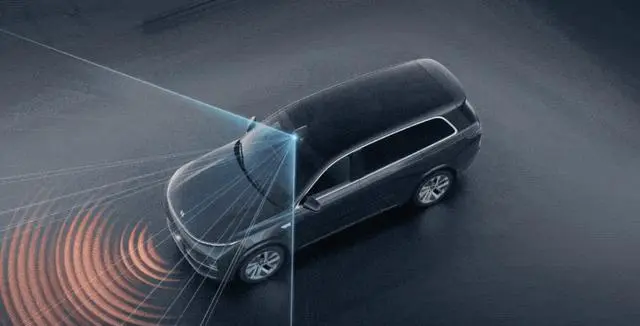

举个简单的例子,车辆只装一个或者两个激光雷达,因为FOV视场受限的问题,会出现很大的探知类死角。这个和我们坐在车内,车辆周围出现很大的视觉盲区是一个道理。

比如车头上方装一个激光雷达,自然就会有左侧面、右侧面、后面的盲区。

而由于FOV的限制,你可以把固定式激光雷达的扫描范围看做一个类光锥,这个光锥之外的,都是看不到的。同时这个光锥可能还会受到车辆本身的干扰,比如在车顶上的激光雷达左右的扫描会被挡风玻璃遮住,向前的扫描会被引擎盖挡住。单个激光雷达的盲区如此之大,这也是为什么某些把激光雷达放在如图所示位置的车型,对于那些从侧面出现,以较快速度斜插到前面的车,经常感应不到而直接追尾的原因了。

之前有个统计,如果要让激光雷达全覆盖,基本让车辆没有死角的话,至少要用8个激光雷达。

同理,精度不够的摄像头、毫米波雷达、超声波雷达也需要全覆盖,才能保障车辆没有死角,在车周围形成一个全方位的探测茧。

而装齐这些硬件,配上足够的算力芯片,成本100%会上到一个天价,除了顶级的豪车,估计没有品牌可以承受,现阶段更没有量产车敢这么做。而即便豪车上齐了硬件,但是软件随着硬件的复杂,又到了另一个无法妥协的阶段,难上加难估计都是少说了的。

而车辆软硬件都过关了,可以放心大胆开自动驾驶了吗?当然还不够,因为这种探测只是针对自车周围的无死角感知,但并没达到交通的无死角感知。

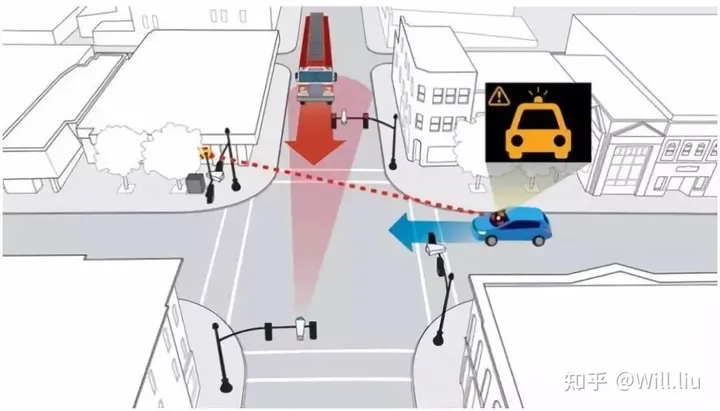

比如十字路口另一端的来车,被高大建筑物、周边大型车辆或者绿植所遮挡,这些无法被自身车辆探知的盲区一样会造成重大的交通事故。

所以,要达到日常非封闭路面上的安全自动驾驶,还必须发展V2X(车辆到一切)——允许车辆与交通系统周围的移动部分进行通信的技术,包括“云、路、设备、车”的交互。

这又是另外一个方面的需求了,而且远比车辆自己加各类硬件更耗费资源的需求,这就更需要政府的集中策划和投资了。

所以,难点如此之多,十年内大概率是看不到真正的全路段自动驾驶的。倒是L3(封闭路段有条件自动驾驶)相关的法律法规、保险条款落地,减少事故、减少拥堵、代替非复杂路况的驾驶,在两三年后还有可能真正看到了。

来源:知乎 www.zhihu.com

作者:Will.liu

【知乎日报】千万用户的选择,做朋友圈里的新鲜事分享大牛。 点击下载

此问题还有 359 个回答,查看全部。

延伸阅读:

自动驾驶汽车采用摄像头和采用雷达各有什么优势?

自动驾驶一定要有激光雷达吗?特斯拉FSD BETA9.0连毫米波雷达都不用了,还能买吗?