发表于

2025-06-11 10:27:36

Mistral Magistral:纯强化学习炼就的推理引擎,颠覆LLM训练范式

发表于

2025-06-11 02:53:07

小红书dots.llm1:重新定义MoE效率边界,14B激活参数挑战72B密集模型极限

发表于

2025-06-06 02:08:33

Qwen3 Embedding 技术解析:多语言文本嵌入与重排序的新标杆

发表于

2025-05-30 07:13:14

解密小米MiMo-VL:7B小模型如何实现多模态SOTA性能

发表于

2025-05-27 07:05:58

QwenLong-L1:通过强化学习实现长上下文推理的大模型飞跃

近年来,大型推理模型(Large Reasoning Models, LRMs)在数学、编程和逻辑推理等任务中展现了接近人类专家的能力。然而,短上下文推理任务的优势能否扩展到长上下文场景(如处理数万token的文档问答)仍是一个关键挑战。阿里巴巴团队提出的QwenLong-L1框架,通过强化学习(RL)和渐进式上下文扩展策略,首次在长上下文推理任务中实现突破性性能。本文将从技术背景、方法创新、实验结果和实际案例等方面解析这一研究成果。一、长上下文推理的挑战与解决方案1.1 问题背景:短上下文与长上下文推理的本质差异传统LRMs(如GPT-4、Claude等)的RL优化主要针对短上下文任务(如4K token内的数学题),其依赖模型内部参数知识生成推理链。然而,长上下文推理(如120K token的金融报告分析)需要模型从外部长文本中检索信息并逐步整合,这对训练效率和稳定性提出了更高要求。实验发现,长上下文RL训练存在两大核心问题:训练效率低下:奖励收敛延迟,输出熵降低导致探索不足。优化过程不稳定:KL散度波动剧烈,长输出序列引入方差放大效应。1.2 QwenLong-L1的核心创新QwenLong-L1提出了一套系统性解决方案,包含三大核心组件:渐进式上下文扩展:分阶段增加输入长度(如20K→60K→120K),避免模型因突变的长上下文输入而崩溃。混合奖励机制:结合基于规则的精确匹

...继续阅读

(56)

发表于

2025-05-16 01:27:55

英伟达选择阿里千问背后的技术逻辑:中国开源大模型的全球崛起

发表于

2025-05-15 10:42:30

深度解析DeepSeek-V3:硬件与模型协同设计如何突破LLM规模化瓶颈

发表于

2025-05-13 14:41:40

Qwen3技术解析:开源大模型的新标杆,附Qwen3技术报告英中对照版

近年来,大型语言模型(LLM)在通用人工智能(AGI)领域持续突破,而开源社区的贡献正不断缩小与闭源模型的差距。由Qwen团队推出的Qwen3系列模型,以其创新的架构设计、高效的多语言支持和卓越的性能表现,成为当前开源大模型领域的焦点。本文将从技术角度解析Qwen3的核心亮点及其背后的设计哲学。一、Qwen3的核心创新1. 动态思维模式:推理与响应的灵活切换Qwen3首次将思考模式(Thinking Mode)和非思考模式(Non-Thinking Mode)整合到同一模型中。思考模式适用于需要多步推理的复杂任务(如数学证明、代码调试),模型会生成详细的中间推理过程。非思考模式则针对即时响应场景(如聊天、简单问答),直接输出最终结果,显著降低延迟。用户可通过在输入中添加/think或/no_think标签动态切换模式,甚至设置思考预算(Thinking Budget)以控制推理深度,平衡性能与计算成本。2. 混合专家(MoE)架构的优化Qwen3提供密集(Dense)和MoE两种架构,其中旗舰模型Qwen3-235B-A22B采用MoE设计,总参数量235B,每Token仅激活22B参数。相比前代Qwen2.5-MoE,Qwen3-MoE通过细粒度专家分割和全局批量负载均衡损失优化专家分工,在相同激活参数下性能提升20%以上。3. 多语言能力飞跃预训练数据覆盖119种语言和方言(前

...继续阅读

(41)

发表于

2025-05-06 10:21:46

Llama-Nemotron:高效推理大模型的技术突破与应用前景

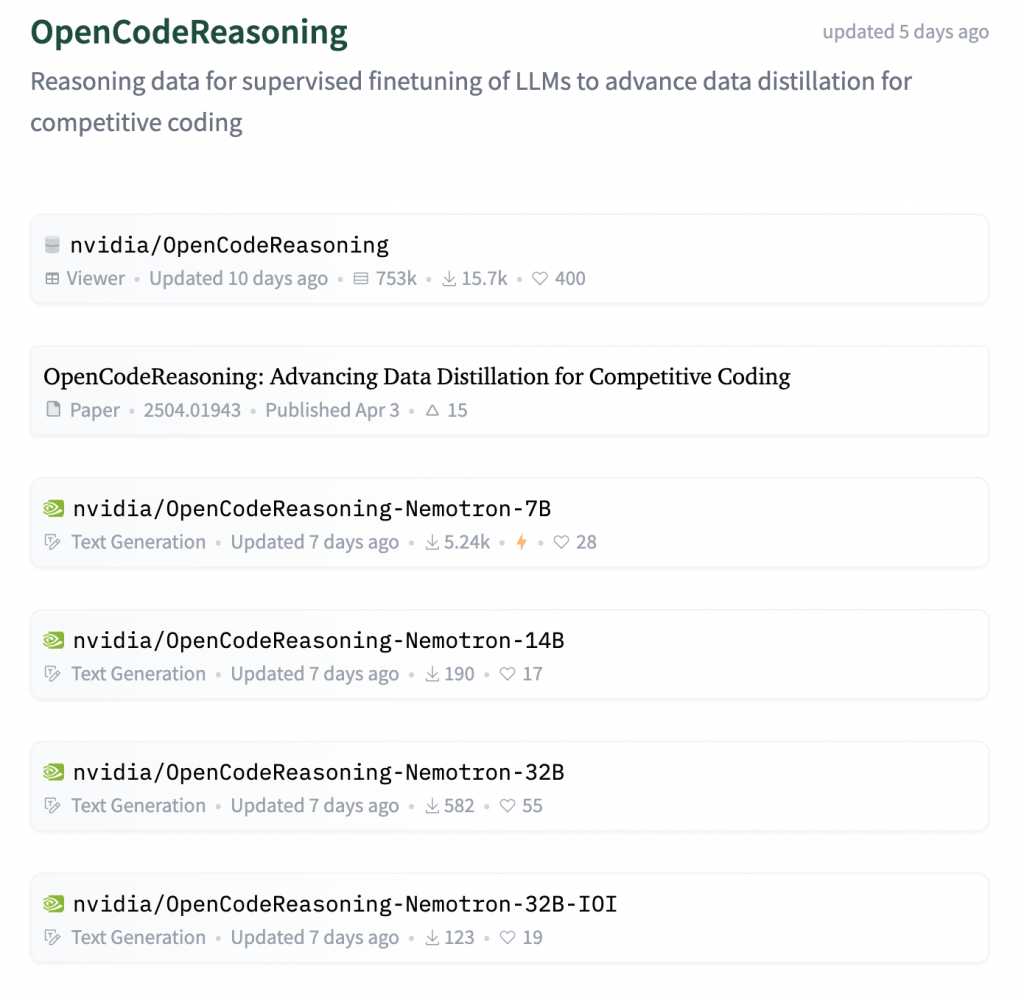

近年来,大型语言模型(LLM)在复杂推理任务(如数学解题、代码生成、科学问答)上的表现突飞猛进。然而,推理效率和用户控制能力逐渐成为制约模型实际落地的核心挑战。针对这一痛点,NVIDIA 近期发布了 Llama-Nemotron 系列模型,以开放许可、高效推理和动态控制为核心卖点,在性能与效率之间实现了新的平衡。本文将深入解析这一技术报告,揭示其背后的技术革新与应用潜力。一、核心亮点:为什么关注 Llama-Nemotron?1. 动态推理切换:按需调整模型行为用户只需在输入中添加 "detailed thinking on/off" 系统提示,即可实时切换模型的响应模式:推理模式(On):生成多步思维链、自我验证和回溯,适合解决复杂问题(如竞赛级数学题)。聊天模式(Off):直接输出简洁答案,适用于日常对话或低复杂度任务。这一功能通过指令微调实现,无需为不同模式部署独立模型,显著降低了部署成本。2. 极致的推理效率优化通过 Puzzle 框架(神经架构搜索工具)和 FFN 融合技术,模型在保持高性能的同时大幅提升推理速度:LN-Super(49B):单块 H100 GPU 上推理吞吐量比 Llama 3.3-70B 快 5 倍。LN-Ultra(253B):在 8xH100 节点上,延迟比原版 Llama 3.1-405B 降低 1.71 倍,内存占用减少 40%。3. 开源生态

...继续阅读

(33)

发表于

2025-05-01 23:16:17

DeepSeek-Prover-V2:形式化数学推理的范式突破

一、引言:形式化定理证明的困境与机遇在数学研究的圣殿中,形式化定理证明始终扮演着"终极验证者"的角色。从欧几里得的《几何原本》到现代数学的ZFC公理体系,严格的形式化证明始终是数学真理的基石。然而,这一过程长期面临两大挑战:人类认知瓶颈:数学家需要将直觉性思维转化为符号逻辑系统(如Lean/Coq)的严格推导,这种"思维编译"过程耗时且易错。机器可解释性缺失:传统自动定理证明器依赖硬编码规则,难以处理开放域的高阶抽象推理。DeepSeek-Prover-V2的诞生,标志着神经定理证明(Neural Theorem Proving)进入新纪元。该模型在MiniF2F-test上达到88.9%的通过率,首次在形式化推理领域逼近人类顶尖选手水平,其技术突破值得深入解析。二、技术架构:三阶递进的智能证明引擎2.1 递归子目标分解(Recursive Subgoal Decomposition)核心思想:模仿人类数学家的"分治策略",将复杂定理分解为可独立验证的引理链。实现步骤:自然语言草图生成:DeepSeek-V3将原始问题转化为非正式证明大纲lean4复制下载-- 示例:IMO 1963 P5的非正式推理 "观察到cos(π/7) - cos(2π/7) + cos(3π/7)的对称性,尝试使用倍角公式展开..."形式化子目标标记:将大纲转换为Lean4语句,用sorry标注待证子目标

...继续阅读

(39)

发表于

2025-04-30 06:48:47

小米MiMo-7B技术报告深度解读:如何打造面向推理的高效大模型?

近日,小米LLM-Core团队发布了MiMo-7B技术报告,详细介绍了其专为复杂推理任务设计的大语言模型系列。该模型通过创新的预训练与后训练策略,在数学、编程及通用推理任务中表现卓越,甚至超越参数量更大的主流模型。本文将深入解析其核心技术,探讨其设计思路与性能优势。核心亮点速览推理潜力爆发:7B参数的MiMo-7B-Base在数学与编程任务中超越32B量级模型。两阶段优化:预训练阶段通过数据优化与多令牌预测(MTP)强化基础能力,后训练阶段基于强化学习(RL)实现精准调优。高效基础设施:无缝滚动引擎将训练速度提升2.29倍,验证速度提升1.96倍。开源共享:完整模型检查点(Base、SFT、RL)已开源,推动社区研究。预训练:为推理而生的数据与架构设计1. 数据优化:密度与多样性并重高质量数据提取:开发专用HTML解析工具,保留数学公式与代码片段,提升推理模式密度。三阶段混合策略:阶段1:平衡数据分布,过滤低质量内容(如广告、新闻),提升专业领域数据权重。阶段2:数学与代码数据占比增至70%,强化专项能力。阶段3:引入10%合成推理数据(数学、代码、创意写作),上下文长度扩展至32K。数据规模:总计25万亿Token,覆盖网页、论文、代码、书籍及合成数据。2. 模型架构创新:速度与性能的平衡基础架构:采用类Llama的Decoder-only Transformer,集成GQA(分

...继续阅读

(30)

发表于

2025-04-29 01:19:47

Qwen3来了,全尺寸开源,性能拉满!附最新一手实测!

发表于

2025-04-27 06:59:23

Kimi-Audio:开源音频基础模型的技术突破与应用前景

近年来,随着大语言模型(LLM)的飞速发展,音频处理领域也迎来了革命性突破。近日,月之暗面(Moonshot AI)团队发布了Kimi-Audio,一款开源的音频基础模型,支持音频理解、生成与对话任务,并在多个基准测试中刷新了性能记录。本文将深入解读其技术报告,剖析其创新设计与应用价值。一、为什么需要统一的音频基础模型?音频是人类感知环境、情感表达和语言交流的重要媒介。然而,传统音频处理技术(如语音识别、语音合成)通常针对单一任务设计独立模型,存在以下问题:任务孤立:不同模型之间无法共享知识,导致开发成本高;数据瓶颈:高质量标注数据稀缺,模型泛化能力受限;模态割裂:音频与文本的联合理解与生成能力不足。Kimi-Audio的目标是构建一个通用音频基础模型,通过统一架构处理多种任务(如语音识别、音频问答、语音对话),同时开源代码与工具,推动社区共同发展。二、核心技术亮点1. 混合音频分词器:兼顾语义与声学细节Kimi-Audio采用离散语义标记(12.5Hz)与连续声学向量结合的输入表示:语义标记:基于ASR模型的向量量化层生成,聚焦内容信息;声学向量:通过Whisper模型提取,捕捉音色、情感等细节。两者叠加后输入音频LLM,平衡了语义理解与声学建模能力。2. 双分支LLM架构:文本与音频联合生成模型核心基于预训练LLM(Qwen2.5 7B)初始化,并扩展为双分支结构:共享层:底层

...继续阅读

(35)

发表于

2025-04-22 06:24:33

开源 AI 短剧神器来了!SkyReels-V2 与 A2 正式登场

发表于

2025-04-20 03:25:11

SkyReels-V2:打破界限的无限长度电影生成模型

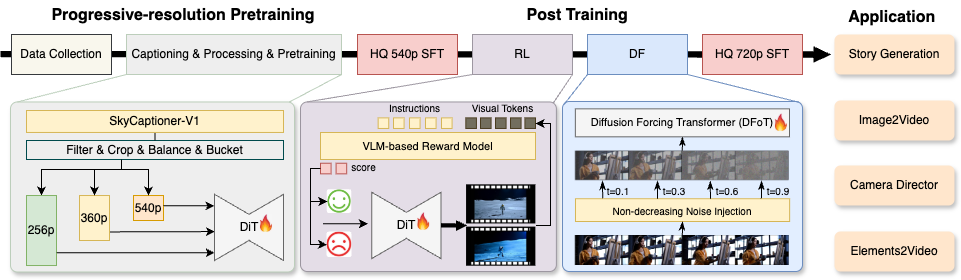

近年来,视频生成技术因扩散模型(Diffusion Models)和自回归模型(Autoregressive Models)的突破而飞速发展,但专业影视制作仍面临诸多挑战:如何平衡提示遵循性、视觉质量、动态运动和视频长度?如何理解复杂的“镜头语言”(如构图、演员表情、摄像机运动)?Skywork AI团队最新开源的SkyReels-V2通过多模态大语言模型(MLLM)、多阶段训练、强化学习和创新的扩散强制框架(Diffusion Forcing),交出了一份令人惊艳的答卷。本文将深入解析这一技术突破的核心思想与应用价值。一、视频生成的挑战与现有方案的局限传统视频生成模型往往需要在多个维度上妥协:提示遵循性不足:通用多模态模型难以理解专业影视的镜头语言(如“特写镜头”“低角度拍摄”),导致生成内容偏离预期。运动质量欠佳:模型倾向于生成静态或机械化的动作,动态细节(如人物表情变化、物理规律遵循)容易失真。视频长度受限:现有模型通常只能生成5-10秒的短视频,长视频生成时会出现时间不连贯或分辨率下降。现有方案如扩散模型(高画质但时间碎片化)和自回归模型(长视频但分辨率低)各有优劣,而结合两者的“扩散强制框架”虽提出已久,却因训练不稳定和搜索空间过大难以实用化。二、SkyReels-V2的核心创新1. 结构化视频表示与高效标注SkyCaptioner-V1:通过融合通用MLLM(如Qwen

...继续阅读

(33)

发表于

2025-04-15 03:16:12

OpenAI GPT-4.1 API 发布及简介

OpenAI今晨推出了 GPT4.1,这是官方介绍:https://openai.com/index/gpt-4-1/以下是关于GPT-4.1的详细介绍,基于官方网页内容:GPT-4.1 简介GPT-4.1 是 OpenAI 最新推出的 GPT 系列模型,具有以下核心特点:性能提升:在编码、指令遵循和长文本处理方面显著优于 GPT-4o 和 GPT-4.5。支持长上下文:支持处理高达 100 万个 token 的上下文(比 GPT-4o 的 128,000 token 大幅提升)。模型家族:包括 GPT-4.1、GPT-4.1 mini 和 GPT-4.1 nano,分别针对不同性能和成本需求优化。知识截止日期:更新至 2024 年 6 月。性能提升编码能力SWE-bench Verified:GPT-4.1 在该基准测试中得分为 54.6%,比 GPT-4o 提升了 21.4%(绝对值),比 GPT-4.5 提升了 26.6%(绝对值)。代码生成与修改:GPT-4.1 在生成代码、处理代码差异(diff)和前端开发方面表现出色,减少了不必要的修改,并能更可靠地遵循格式要求。实际案例:Windsurf:GPT-4.1 在内部编码基准测试中得分比 GPT-4o 高出 60%,代码修改接受率更高,重复修改的可能性降低 50%。Qodo:在代码审查任务中,GPT-4.1 在 200 个实

...继续阅读

(32)

发表于

2025-04-13 03:30:43

Seed-Thinking-v1.5:用强化学习推动语言模型的深度推理能力

近日,字节跳动发布了新一代推理模型 Seed-Thinking-v1.5,其在数学、编程、科学等复杂任务中表现卓越,同时在非推理场景(如创意写作)中也展现了强大的泛化能力。本文将从技术亮点、核心方法、实验结果等方面,解读这一模型的突破性进展。一、为什么Seed-Thinking-v1.5值得关注?Seed-Thinking-v1.5 是一个基于 混合专家架构(MoE) 的模型,激活参数量为200亿,总参数量达2000亿。尽管规模适中,但其在多个基准测试中表现亮眼:数学推理:在AIME 2024(美国数学邀请赛)中得分86.7%,与OpenAI的o3-mini-high持平,远超DeepSeek R1。编程任务:在Codeforces竞赛的pass@8指标(8次生成中至少一次正确)达到55%,显著优于同类模型。科学问答:在GPQA(复杂科学问题数据集)中准确率达77.3%,接近顶尖模型水平。非推理任务:用户满意度比DeepSeek R1提升8%,尤其在创意写作和知识问答中表现突出。更引人注目的是,团队提出了 BeyondAIME 和 Codeforces新评测集 两个内部基准,旨在解决传统评测(如AIME题目过少)的局限性,未来将开源供社区使用。二、核心技术:数据、算法与基础设施的协同优化Seed-Thinking-v1.5的成功源于三大支柱的深度融合:1. 数据:质量与多样性并重可

...继续阅读

(30)

发表于

2025-04-10 02:54:26

Kimi-VL:开源多模态模型的新标杆——解读高效视觉语言混合专家模型

引言随着人工智能技术的飞速发展,多模态模型正逐渐成为人机交互的核心。然而,开源社区在视觉语言模型(VLM)领域的进展长期滞后于闭源产品。Kimi团队近期发布的Kimi-VL技术报告,展示了一款兼具高效性与强大能力的开源多模态模型。本文将从技术架构、训练策略、性能表现等方面深入解读这一突破性成果。核心亮点:Kimi-VL的三大创新1. 混合专家架构(MoE)的极致优化Kimi-VL采用2.8B激活参数+16B总参数的MoE语言模型(Moonlight)与**400M参数原生分辨率视觉编码器(MoonViT)**结合,显著降低了计算成本。MoonViT支持任意分辨率图像输入,避免传统模型的图像分割拼接操作,通过2D旋转位置编码(RoPE)提升高分辨率细节感知。MoE语言模型利用专家并行(EP)与上下文并行(CP)技术,训练吞吐量比7B密集模型高60%,在长序列处理中内存占用降低30%。2. 128K上下文窗口与长链推理能力模型通过长上下文激活阶段(从8K扩展至128K)和强化学习驱动的长链思维微调,实现超长多模态输入的理解:在LongVideoBench(长视频问答)和MMLongBench-Doc(百页文档理解)中,分别以64.5%和35.1%的准确率超越同类模型。Kimi-VL-Thinking变体通过“规划-评估-反思”推理链,在MathVista(68.7%→71.3%)和Ma

...继续阅读

(29)

发表于

2024-10-16 09:21:39

探索3D打印与增材制造课程:转变创意为现实的艺术之旅

课程主页:https://www.coursera.org/specializations/3d-printing-additive-manufacturing大家好!今天我想和大家分享一个来自伊利诺伊大学香槟分校的神奇课程——《3D打印与增材制造》。爱好创意与技术的朋友们千万不要错过!这个课程将开启您将想法变为实际物体的全新视野。通过深入的知识获取,您会了解3D打印的工作原理,及其在各个领域的应用,从制造到医疗,让您的设计思维挑战传统的边界。课程概述:下列是该课程的结构及信息:3D打印革命- 该模块将介绍3D打印机是如何工作的以及人们如何利用3D打印机制作各种各样的产品。3D打印应用- 学习识别3D打印的多种应用,包括工程与设计等领域。3D打印软件- 掌握使用专业软件创建和优化3D打印模型的技能。3D打印硬件- 深入了解桌面级3D打印设备,包括其组成和选择指南。3D打印顶点项目- 一次整合四个课程所学的实践经验。这些内容结合了理论知识和实际应用,尤其值得一提的是最后的Capstone项目,您可以展示自己在整个学习过程中掌握的技能,无论是自己的设计、打印物料还是优化的打印流程,都将由您来一手完成!如果您是一位对创新充满热情,渴望将创意付诸实践的人,这个课程您绝对不可错过不仅可以获得专业知识,还能扩展自己的技能与视野。对于那些追求技术前沿和创意转型的人来说,这是一次不可多得的机会。赶

...继续阅读

(72)

发表于

2024-10-16 09:21:30

课程推荐:会计数据分析课程回顾

课程主页:https://www.coursera.org/specializations/accounting-data-analytics作为一名学生,数据分析技能在现代会计中变得越来越关键。我最近在Coursera上完成了由伊利诺伊大学香槟分校(University of Illinois at Urbana-Champaign)提供的“会计数据分析”课程,想在这里分享我的学习体验并给予推荐。### 课程概述“会计数据分析”是一门专为未来的会计师设计的课程,其不仅将传统会计知识与现代数据分析技能相结合,还帮助学生掌握很多 Python programming、生意数据汇集以及机器学习的应用等高级技能。### 课程大纲1. **会计数据分析与可视化导论**:[(y之連結)](https://www.coursera.org/learn/intro-accounting-data-analytics-visual)本模块讨论分析思维在会计中的重要性,以及如何巧妙地将数据呈现给非技术唐涩夏。2. **使用 Python 的会计数据分析**:[(y之連結)](https://www.coursera.org/learn/accounting-data-analytics-python)这个模块深入讲解 Python 的应用,它帮助会计专业学生有效挖掘商情数据,通过编程能力指导日常会计

...继续阅读

(45)

发表于

2024-10-16 09:21:17

如何利用Coursera的《大学成功学术技能》课程提升您的学习能力

发表于

2024-10-16 09:20:59

提升写作技能的课程推荐:学术英语写作培训

课程主页:https://www.coursera.org/specializations/academic-english在日常生活和学术环境中,出色的写作能力对于成功至关重要。对于那些希望提升写作技能的人,加州大学欧文分校提供的《学术英语:写作》课程系列尤其值得关注。这四个课程组成的系列从基础开始帮助学生掌握语法、论文写作、高级写作技巧,直至研究中所需的写作。那么,该课程究竟适合怎样的学员?又有什么样的亮点呢?下面,我就将为大家详细解析。课程概述该系列课程包括以下四大模块:语法与标点- 一开始对于很多人来说,这可能是重温的一个很好的机会,无论你是刚接触英语还是已经学会多年。写作入门:论文- 本课程专注于帮助学生学习和设计论文写作的过程。高级写作- 让学习者提高作品的质量,同时掌握结构与内容安排的细节。论文写作导论- 提供研究的基础知识,为学生提供研究方法与写作能力之间的关联。此系列还包括一个写一个研究论文的结课项目,让参与者在实际写作时锻炼自己的能力。学习体验首先,该课程的优点在于其系统性与循序渐进。每个模块难易适中,由深入浅出的丽丽达与教授讲解,《学术英语:写作》将英语学术写作变得易懂和贴近实践,这对于非母语的同学特别重要。互动式的教学方式也是该课程的一大亮点:无论是在写作练习、同行评审还是讨论环节中,都能让学生积极参与,构建自己的批判性思考。同时,完备的反馈机制能让同学了解

...继续阅读

(49)

发表于

2024-10-16 09:20:27

探索STEM教育的未来:评测Coursera课程《利用PhET互动模拟体验主动学习》

课程主页:https://www.coursera.org/specializations/active-learning-in-stem-with-phet-interactive-simulations在当前的教育环境中,科技正在以前所未有的速度重塑我们的学习方式。近日,我注册参加了Coursera上由科罗拉多大学博尔德分校开设的课程《利用PhET互动模拟体验主动学习》,此课程专注于如何通过免费的数学和科学互动模拟来增强学生的学习体验。课程概述:PhET互动模拟提供了一系列有趣的数学和科学模拟工具,旨在帮助学生启発思考和理解复杂概念。这些模拟不仅富有互动性,而且操作简单,适合各个年龄段的学习者。课程本身完全免费,让更多人有机会接触并使用这些优秀的教育资源。课程大纲:PhET模拟介绍全班使用PhET模拟利用PhET模拟设计活动实施PhET活动每个部分都通过真实的实例展示了如何有效使用这些模拟器,并提升课堂进行中的互动。当课程涉及如何设计活动、与同学一起利用PhET进行学习、以及实施这些活动时,我感到特别激动,这为我带来了许多启发。我的推荐理由:如果你是一位教师或对STEM教育感兴趣的学习者,那这门课程绝对值得一试。它告诉我,互动学习不仅限于传统的学习方式,而是可以通过现代科技深入浸入你的课堂。”PhET让我的学生亲手操作、体验和引导探索,从而投入更深的思考。“综上所述,参加这个课

...继续阅读

(85)

发表于

2024-10-16 09:20:18

课程推荐:这是你了解异常心理学的绝佳机会!

课程主页:https://www.coursera.org/specializations/abnormal-psychology大家好!如果你对心理学感兴趣或者想了解更多关于精神疾病和心理行为的问题,那么《异常心理学》这门课程非常值得推荐!这门课程是由著名的韦斯利大学提供,课程内容丰富,涵盖异常心理学的主要领域。无论你是心理学的新手,还是已经有一定基础的学习者,这门课程都能帮助你更深入地认识精神健康。### 课程大纲异常心理学入门:包含异常心理学的基本概念与重要的领域。精神疾病历史:探讨精神疾病的发展历程以及我们对这些疾病的不同理解。行为改变:学习如何理解和改变心理和身体健康行为的课程。课程采用视频讲座、阅读材料和知识测验等多种形式,学习方式灵活多样,非常方便。如果你对异常心理学的专业知识和 trendy 的情感管理感到好奇,绝对不妨试试!66% 的学生在课程结束时反映他们的关注度提升。他们在心理健康方面能够更知情,以上三部分组合中,不仅帮助你建构重要的知识体系,还能针对实际生活中的难题,提高你的解决能力。小编强烈推荐这个课程,它不仅适合专业学习,也适合对心理疾病特征感兴趣的大众。不论你出于何种原因去学习,相信会收获很多!课程主页:https://www.coursera.org/specializations/abnormal-psychology

...继续阅读

(78)

发表于

2024-10-16 09:20:02

深入了解光学器件课程:从基础到设计

发表于

2024-10-16 09:19:45

学习3D打印的未来:阿纳မ္萨州立大学的增材制造课程推荐

课程主页:https://www.coursera.org/specializations/additive-manufacturing今天,我想向大家介绍一个非常有趣且富有前景的在线课程——阿纳姆萨州立大学的增材制造课程。这是探索3D打印世界的一个理想起点。如果您对制造行业的最新趋势感兴趣,特别是关于增材制造(或3D打印),这个课程绝对是不容错过的机会。课程简介:该课程提供了有关增材制造过程的概述。这一领域近年来蓬勃发展,从原型制造,到艺术创作,再到航空航天和医疗行业的实际应用。通过恢复成熟的项目,您将取得较快的实战经验。课程大纲概览增材制造过程简介材料挤出材料喷射与立体光刻选择性激光烧结及金属激光粉末床熔化增材制造设计想了解更多的内容,我们建议您仔细深入研究:这门课程不仅让我了解了很多酷炫的3D打印技术,还让我可以思考如何在我自己未末的一些项目中应用这些技艺。case背后的动机及其广泛为我们连接发动。综上所诉,这门课程提供令人满意的理论知识,并带领我们走革,取走许多实用知识。我强烈推荐使用这个机会提升自己的意识,收获尖端科技的精华。快去注册链接报名吧,和全世界的学习者一起走向3D打印的未来!课程主页:https://www.coursera.org/specializations/additive-manufacturing

...继续阅读

(46)

发表于

2024-10-16 09:19:25

深入了解Akamai客户咨询与支持课程 —— 职业新起点的理想选择

课程主页:https://www.coursera.org/professional-certificates/akamai-customer-consulting-and-support如果你对客户咨询与支持领域充满热情,Akamai Technologies, Inc.提供的《Akamai客户咨询与支持课程》将成为你迈向职业生涯的绝佳起点。这门课程不仅提供全面的知识体系,更注重实际应用的练习,深度剖析了客户服务的361度角,为学员打开了学习和成长的大门。### 课程概览《Akamai客户咨询与支持课程》的主要目的在于帮助学员掌握有效的客户沟通技巧,熟悉支持流程和相关技术。这门课程由Akamai的行业专家教授,内容涵盖:### 操作系统基础:a href="https://www.coursera.org/learn/akamai-operating-systems"目标覆盖Linux操作系统的基本功能,帮助学员建立扎实的操作系统知识基础。### 网络基础:a href="https://www.coursera.org/learn/akamai-networking"目标介绍网络理论和术语,学习网络组件和其基本工作原理,让你在咨询过程中更具专业性。### Web应用入门:a href="https://www.coursera.org/learn/akamai-web-apps

...继续阅读

(53)

发表于

2024-10-16 09:19:15

学习与就业的一把钥匙:Macquarie University的《适应:职业发展》课程介绍与评价

课程主页:https://www.coursera.org/specializations/adapting-career-development简介你是否是否仍对自己的职业发展感到迷茫?是否曾想过提升个人职业发展能力,以更好地适应不断变化的职场环境?来自麦考瑞大学的Coursera课程《适应:职业发展》将会是一个令你收益匪浅的选择。课程概览这个课程探讨了多个重要的职场主题,包括个人韧性、文化智力、职业规划与职业自我提升等。各个模块的设计为令学员能够更灵活地应对当今快节奏和激烈竞争的工作环境。1.建立个人韧性: 在现代24小时工作市场中如何提升自我抵抗力?2.文化智力:成为全球公民: 学习如何跨越文化差异,并与不同背景的人有效沟通。3.职业规划:你的职业,你的生活: 思考自己的职业目标和发展范围。4.职业发展:不断改善自我: 在变化中的世界中不断寻找自我提升的机会。个人评价这门课程不仅是知识的传递,更提供了有效建设自我、提升意识实力的机会。受到来自业界的真实案例与实用策略的浇灌,每一个模块都有积极而深刻的雅思体验。 سواء你是一名刚毕业的学生还是一位职场人士,这门课程都能够提升你的职业敏锐度和执行能力。在日益变化的工作环境下,同学们可以在这里学到如何使用丰富的文化视野来更好地与团队沟通,实现真正的跨文化合作。总结与推荐无论是建立个人韧性,还是增强文化智力,麦考瑞大学的《适应:职业

...继续阅读

(49)

发表于

2024-10-16 08:20:50

数据素养课程评测:让你成为数据驱动的领导者

课程主页:https://www.coursera.org/specializations/data-literacy随着大数据时代的到来,数据素养已经成为现代人员的必备技能。作为世界顶尖的在线学习平台之一,Coursera提供了由约翰霍普金斯大学开设的数据素养课程,旨在帮助学员掌握解读和利用数据的基本要素。在这篇文章中,我们将详细评测这一课程,并分享我们的看法与推荐。课程概况:该课程共包含五个部分,从数据的基础知识入手,逐步深入数据收集和分析的全过程。第一部分《数据:它是什么,我们能做什么》介绍了数据和统计学的基础知识;第二部分《测量:将概念转化为数据》帮助分析员建立和评估定量测量的框架;第三部分《用回归模型量化关系》使用线性回归模型分析数据预测的重要性;第四部分《几率是什么?统计中的概率和不确定性》讨论如何量化信心和不确定性;最后的第五部分《数据素养最后项目:评估研究》是一个综合性的实战项目,您将在那里应用学习到的技能来全面评估研究。课程评价:从内容来看,該课程结合了理论和实践,通过众多实际案例,使学员更容易理解数据概念。同时,课程和材料不断更新,以确保内容与现代技术和市场动态相符。每个模块结束后都有小测验来帮助学员巩固所学知识,其互动性和参与性都非常高。作为一个希望在商业和科学领域提高数据分析能力的人,这门课程真是非常理想。尤其适合那些没有任何数据或者统计基础的学员,课程特别

...继续阅读

(54)