发表于

2023-10-30 20:53:58

担忧 AI 向人类扔核弹,OpenAI 是认真的

发表于

2023-10-30 16:11:27

检验真极客的时候到了|「2023 年度极客最爱好物」征集启动

发表于

2023-10-30 16:10:47

「极」智新势力 · 2023 智能汽车年度评选 Geek Wheels Awards

发表于

2023-10-30 08:46:53

姚期智等 AI 专家:2025 年 AI 规模暴增 100 倍;对抗英伟达,甲骨文站队 AMD;SHEIN 与 Forever 21 推联合品牌

发表于

2023-10-29 08:26:53

《流浪地球 2》将角逐奥斯卡最佳国际影片;Anthropic 再获 20 亿美元融资;蔚来推出婚庆用车定制服务 | 极客早知道

发表于

2023-10-28 12:54:52

雷军已经想好了小米「全家桶」的新故事

发表于

2023-10-28 12:12:30

赛博厨房的时代,已经到来

发表于

2023-10-28 09:21:29

Model Y 高性能版涨价;华为前三季度收入 4566 亿元;消费者组织警告:ChatGPT 正在助长网络诈骗

发表于

2023-10-27 13:52:15

刚刚,最「卷」物流企业极兔上市:4 年干到东南亚第一、3 年干到中国第五

发表于

2023-10-27 10:06:22

大模型浪潮下,最有志向的公司已经率先办起了 AI 黑客松

发表于

2023-10-26 22:02:07

昨晚小鹏亮了亮「武器库」,股市就嗨了

发表于

2023-10-26 18:44:43

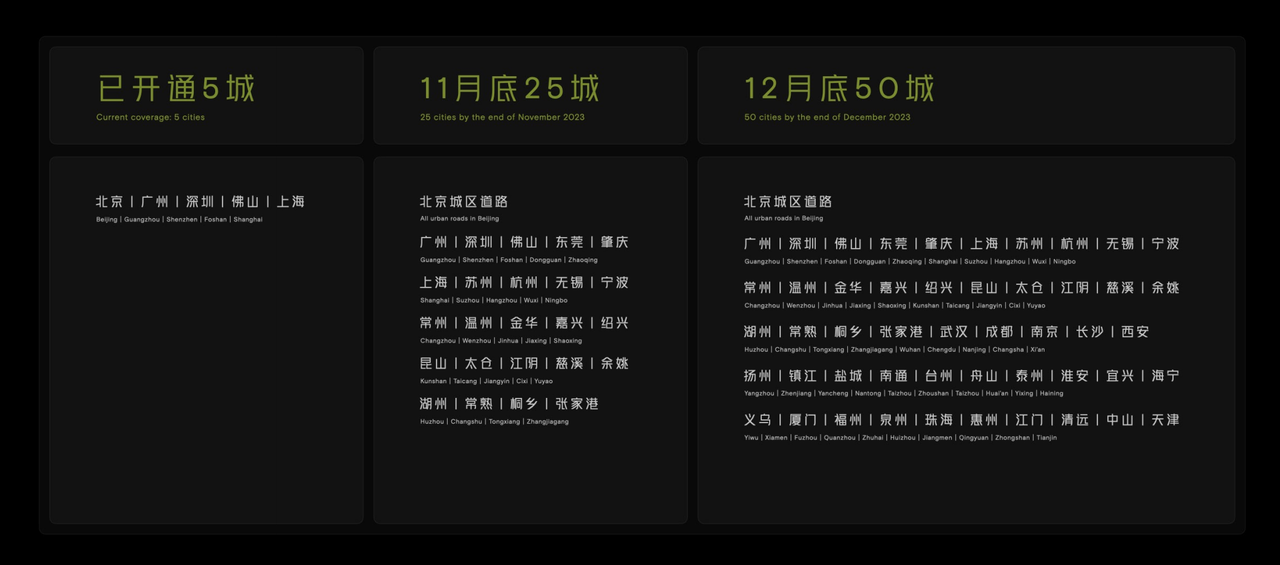

智能驾驶,终于从PPT变成了竞争力

发表于

2023-10-26 16:14:28

一群技术天才决定加入美团

发表于

2023-10-26 09:01:07

云业务疲软,谷歌一夜蒸发 1700 亿美元;零跑与 Stellantis 成立合营公司;华为接管问界销售不实| 极客早知道

发表于

2023-10-25 21:38:33

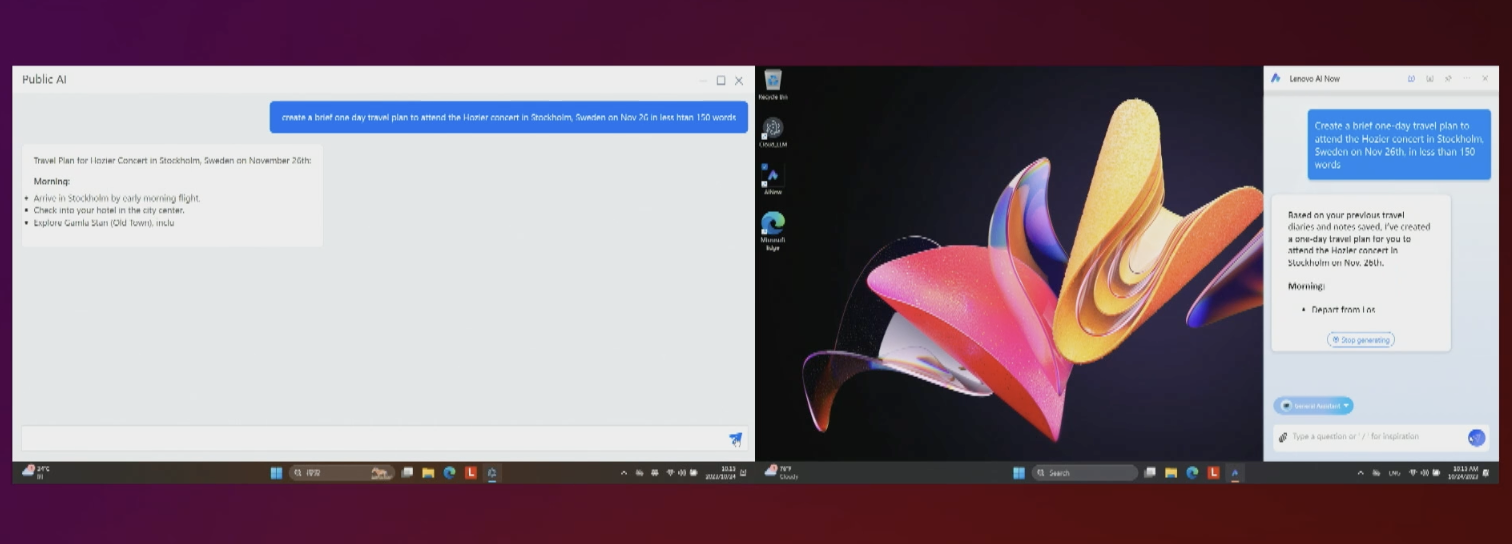

联想发布全球首款 AI PC:可运行「个人大模型」

发表于

2023-10-25 16:43:49

大模型进入行业的 X 种示范| 2023 中国「+大模型」先锋案例 TOP10 评选启动

发表于

2023-10-25 16:35:26

记录生生不息的创新力量|「InnoForce 50」2023 创新评选启动征集

发表于

2023-10-25 16:12:41

拳打苹果、脚踢英特尔,高通芯片才是 AI 的未来

发表于

2023-10-25 11:04:15

对话科大讯飞:不赚钱是 ChatGPT 的问题,不是大模型商业化的问题

发表于

2023-10-25 08:37:12

苹果官宣下周二 Mac 发布会;小鹏发布可量产飞行汽车;胡润百富榜发布,钟睒睒仍为中国首富,马化腾重回第二 | 极客早知道

发表于

2023-10-25 02:16:00

年轻人玩「躲猫猫」有多野?把地图 App 都干懵了

发表于

2023-10-24 08:35:28

雷军公布澎湃OS 完整系统架构;传苹果 2027 年发布折叠屏产品;英伟达开发 Arm 架构 PC 芯片

发表于

2023-10-23 08:40:39

苹果计划每年投资 10 亿美元发展生成式 AI;微信更新聊天消息提示功能;LLM 新缺陷曝光

发表于

2023-10-22 09:50:57

今年双十一,淘天打算怎么搞

发表于

2023-10-22 08:56:21

库克:苹果 95% 产品仍在中国生产;哥斯拉诞生 70 周年大作公布预告;小鹏 X9 设计图曝光,溜背 MPV

发表于

2023-10-21 08:51:44

宿华辞任快手董事长,CEO 程一笑兼任;科大讯飞:华为处理器可对标英伟达 A100;英特尔:2025 发展 1 亿台 AI PC | 极客早知道

发表于

2023-10-20 15:51:01

1% 的份额,100% 的增长,在折叠屏手机里能看到什么?

发表于

2023-10-20 15:47:25

对话百度肖阳:生成式大模型,搜索最重要的一块拼图

发表于

2023-10-20 08:48:51

iPhone 最早明年搭载 AI 功能;OpenAI 廉价版 GPT-4 夭折;新闻出版署:网游不要「又肝又氪」|极客早知道

发表于

2023-10-19 08:26:53

英伟达 4090 显卡被炒至 3 万元;特斯拉发 3 季财报,利润大降 44%;亚马逊仓库测试双足机器人