发表于

2023-04-16 00:00:00

Vue3 ChatGPT Web Scaffold

You:请用Vue3写一个ChatGPT Web脚手架,不同的模块要用不同的文件,比如Chat.vue,Message.vue,Request.vue,Storage.vue,文件夹结构要合理。ChatGPT:创建一个基于 Vue 3 的 ChatGPT Web 脚手架需要以下步骤:首先,确保你已经安装了 Node.js 和 npm。全局安装 Vue CLI:npm install -g @vue/cli创建一个新的 Vue 3 项目:vue create chatgpt-web --preset vue3进入项目文件夹:cd chatgpt-web运行项目:npm run serve现在,我们需要创建一些基本的文件和文件夹结构。在src目录下创建一个名为components的文件夹。在components文件夹中,创建以下文件:Chat.vueMessage.vueRequest.vueStorage.vuesrc

├── components

│ ├── Chat.vue

│ ├── Message.vue

│ ├── Request.vue

│ └── Storage.vue

└── main.js在各个组件文件中,创建基本的 Vue 组件结构。以下是一个示例:Chat.vueChat UI goes hereimportMessagefrom'./Messa

...继续阅读

(40)

发表于

2020-07-18 01:47:00

Vim 基本命令

注意,Vim 区分大小写。移动方向键移动h或←光标左移l或→光标右移j或↓光标下移k或↑光标上移单词移动w(“word”) 光标向右移动一个单词b(“back”) 光标向左移动一个单词e(“end”) 移动光标到当前单词的最后一个字母行首行末移动类似正则表达式^移动光标到行首$移动光标到行末屏幕位置移动H(“high”) 移动光标到屏幕上端M(“middle”) 移动光标到屏幕中端L(“low”) 移动光标到屏幕下端页面滚动Ctrl-f(“forward”) 向下翻页(整个屏幕)Ctrl-d(“down”) 向下翻半页(半个屏幕)Ctrl-b(“backward”) 向上翻页(整个屏幕)Ctrl-u(“up”) 向上翻半页(半个屏幕)插入文本a在光标右侧插入文本A在行末插入文本i在光标左侧插入文本I在行首插入文本o在光标下插入新行O在光标上插入新行修改文本cw删除当前单词的光标右侧部分,进入编辑模式cc将当前行替换为空行,进入编辑模式s删除当前字母,进入编辑模式r替换当前字母,输入一个字母后自动返回命令模式撤销修改u撤销上次修改U撤销对当前行的所有修改Ctrl-r恢复上次修改删除文本删除字母x删除光标右侧字母X删除光标左侧字母删除单词dw(“delete word”) 删除当前单词的光标右侧部分 (cw会进入编辑模式)daw(“delete a word”) 删除光标所在的

...继续阅读

(11)

发表于

2020-07-17 21:47:00

Docker 基本命令

下载镜像docker pull[OPTIONS] NAME[:TAG|@DIGEST]# eg:docker pull nvcr.io/nvidia/pytorch:20.06-py3启动镜像docker run[OPTIONS] IMAGE[COMMAND][ARG...]# eg:docker run--gpusall-ti-v/:/data--ipc=host-p8000:8000--namelufficc nvcr.io/nvidia/pytorch:20.03-py3-it交互模式运行--rm容器退出时自动删除此容器-v绑定磁盘,/:/data即将容器下/data目录映射到主服务器的/目录--ipcIPC mode-p映射端口--name容器名称启动容器docker start[OPTIONS] CONTAINER[CONTAINER...]# eg:docker start lufficc停止容器docker stop[OPTIONS] CONTAINER[CONTAINER...]# eg:docker stop lufficc显示所有容器docker containerls-a进入容器dockerexec-itCONTAINER bash# 如果使用 zshdockerexec-itCONTAINER zsh删除容器dockerrmCONTAINER删除镜像dock

...继续阅读

(11)

发表于

2020-06-10 17:28:21

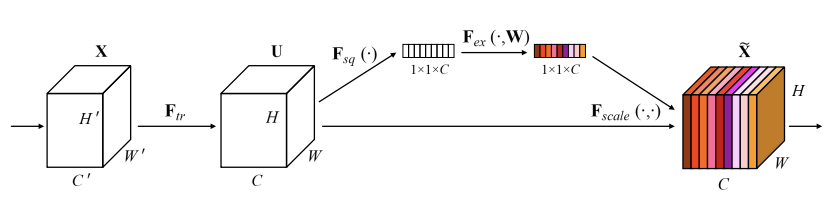

SENet: Squeeze-and-Excitation Networks

发表于

2020-06-10 16:44:58

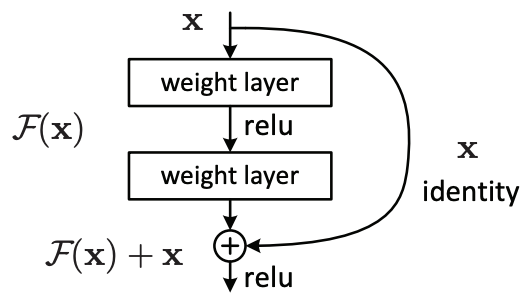

ResNet: Deep Residual Learning for Image Recognition

发表于

2020-05-27 23:12:33

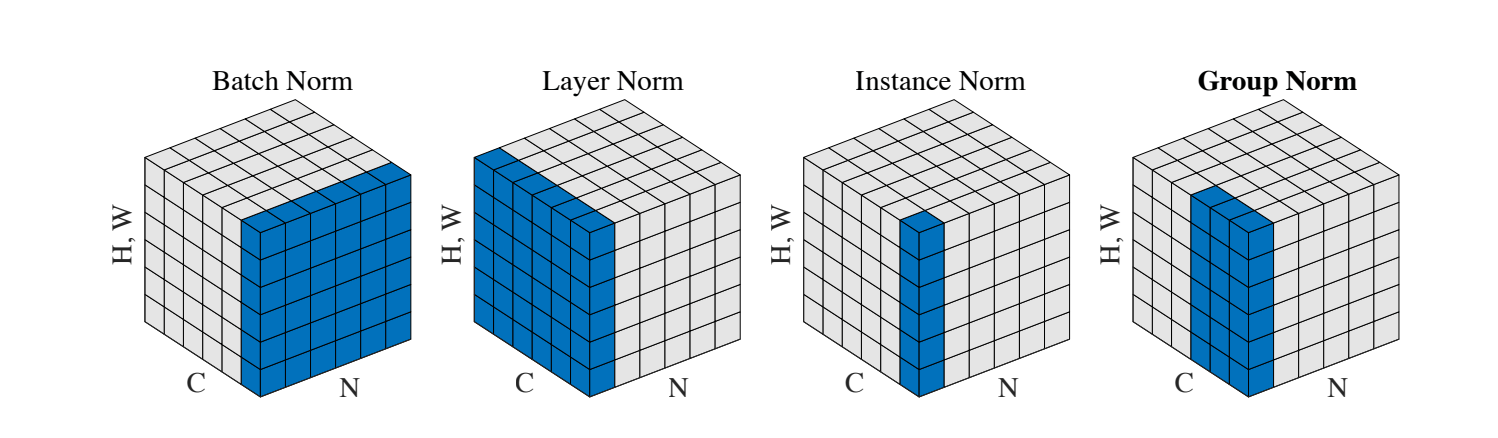

Batch Norm, Layer Norm, Instance Norm, Group Norm

发表于

2020-04-04 22:41:00

如何上传论文到 arXiv

上传你的论文到arXiv,看似麻烦,实则简单。步骤新建文件夹,将mwe.tex和mwe.bib放进去。文件mwe.bib:@Book{Goossens,

author ={Goossens, Michel and Mittelbach, Frank and

Samarin, Alexander},

title ={The LaTeX Companion},

edition ={1},

publisher ={Addison-Wesley},

location ={Reading, Mass.},

year ={1994},}@Book{adams,

title ={The Restaurant at the End of the Universe},

author ={Douglas Adams},

series ={The Hitchhiker's Guide to the Galaxy},

publisher ={Pan Macmillan},

year ={1980},}文件mwe.tex:\documentclass[10pt,a4paper]{article}\usepackage{hyperref}% for better urls\b

...继续阅读

(8)

发表于

2017-10-31 23:36:00

TensorFlow 的 TFRecord 和 QueueRunner 简介

发表于

2017-10-31 03:26:00

用 LSTM 预测字符序列

在循环神经网络(Recurrent Neural Network)简介中我们了解了什么是 RNN,本文用 TensorFlow 实现一个超级简单的字符预测模型,并对代码进行详细说明,防止自己以后忘记( ╯□╰ )。首先定义 RNN 网络:class RNN:

def __init__(self,

in_size,

cell_size,

num_layers,

out_size,

sess,

lr=0.003):

self.in_size = in_size # 输入数据大小,这里为字符数目(注意这里将大写字母转换为了小写字母,减小了字符数目,加快训练)

self.cell_size = cell_size # LSTM cell 的unit数目

self.num_layers = num_layers # 因为是多层LSTM,num_layers指定了层数

self.out_size = out_size # 输出数据大小,同样为字符数目

self.sess = sess # sess

...继续阅读

(13)

发表于

2017-10-27 13:21:12

TensorFlow 和 NumPy 的 Broadcasting 机制

TensorFlow 采用 NumPy 的 Broadcasting 机制,来处理不同形状的 Tensor 之间的算术运算,来节省内存、提高计算效率。NumPy 数组运算通常是逐元素(element-by-element )计算,因此要求两个数组的形状必须相同:>>> a = np.array([1.0, 2.0, 3.0])

>>> b = np.array([2.0, 2.0, 2.0])

>>> a * b

array([ 2., 4., 6.])NumPy 的 Broadcasting 机制解除了这种限制,在两个数组的形状满足某种条件的情况下,不同形状的数组之间仍可以进行算术运算。最简单的就是数组乘以一个标量:>>> a = np.array([1.0, 2.0, 3.0])

>>> b = 2.0

>>> a * b

array([ 2., 4., 6.])结果和第一个b是数组的例子相同。可以认为标量b被拉伸成了和a相同形状的数组,拉伸后数组每个元素的值为先前标量值的复制,这样形式上和第一种例子相同,因此结果当然一样。但这只是理论上的,复制操作并不会真正进行,只是在计算时使用标量的值罢了。因此,第二个例子效率更高,因为节省了内存。Broadcasting 规则当两个数组进行算术运算时,NumPy 从后向前,逐元素比较两个数组的形状。当逐个比较的元素值满足以下条

...继续阅读

(11)

发表于

2017-10-10 12:00:00

常用代码片段

Ubuntu 安装最新 Nginx:sudo-snginx=stable# use nginx=development for latest development versionadd-apt-repository ppa:nginx/$nginxapt-get update

apt-getinstallnginx查看 Mysql 各数据表大小:SELECTtable_schema"DB Name",Round(Sum(data_length+index_length)/1024/1024,1)"DB Size in MB"FROMinformation_schema.tablesGROUPBYtable_schema;安装55:sudoapt-get updatesudoapt-getinstallpython3-pipsudopip3installshadowsockssudo mkdir/var/sssudovim /var/ss/ss.json

ssserver-c/var/ss/ss.json-dstart{"server":"0.0.0.0","server_port":8388,"local_address":"127.0.0.1","local_port":1080,"password":"mypassword","timeout":300,"method":"a

...继续阅读

(10)