发表于

2024-01-08 14:36:00

批量下载github打包文件

wget $(curl -s https://api.github.com/repos/ehang-io/nps/releases/latest | grep -oP '"browser_download_url": "\Khttps://[^"]+')把ehang-io/nps换成你要的github ID和项目地址.

...继续阅读

(91)

发表于

2024-01-04 13:53:11

Adobe illustrator自动排版功能,轻松完成批量排版操作

发表于

2024-01-03 23:36:44

如何批量取消你的 B 站关注和 Youtube 关注

在You Need or You Want?当中,我提到,我在清理我的关注,取消那些我很久不看的频道,简单分享一下如何做这个动作。Youtube 关注YouTube 可以访问Channels页面,然后手动取消关注( Youtube 的取关还有个二次确认,所以没办法像 B 站那样一条命令取消关注当前页面的 所有 Up 主)B 站关注B 站的取消关注动作相对简单很多。由于 B 站提供了按「最常观看」的排序的方式,所以我们只需要选择使用这个排序,并切换到列表最后一页,批量取关即可。批量取关你可以使用下面这个命令,来取关整个页面上的所有 UP 主。$(".be-dropdown-item:contains('取消关注')").click()具体的步骤如下:一、在个人主页打开关注管理页面,并切换至全部关注的「最常访问」排序列表。二、使用 F12 或使用选项打开开发者工具,并切换到 Console 页面(中文是控制台)三、粘贴上面的代码,就可以取消关注当前页面的所有 UP 主了。需要注意的是,每次执行会取关当前页面的,你需要切换一下底部的翻页器,切换到其他页再执行上面的命令。此外,你还需要关注执行频率,如果执行频率太高,可能会弹出一个报错。这个时候只需要刷新一下即可。如何批量取消你的 B 站关注和 Youtube 关注最先出现在白宦成。

...继续阅读

(101)

发表于

2023-12-27 12:36:38

江淮钇为全球首款钠电池量产车即将批量交付

36氪获悉,12月27日,江淮钇为全球首款钠电池量产车正式下线,并将于元旦后开启批量交付。据了解,本次量产车型搭载的是中科海钠供应的钠离子圆柱电芯,并采用江淮钇为独有的蜂窝电池结构。这次量产车的下线标志着全球汽车产业中钠离子电池的首次产业化。

...继续阅读

(14)

发表于

2023-12-27 01:32:59

B端Excel批量导入设计分享

发表于

2023-12-23 15:24:46

从Go channel中批量读取数据

有时候批量积攒一批数据集中处理,是一个高效的提高程序性能的方法,比如我们可以批量写入数据库,批量发送消息到kafka,批量写入网络数据等等。批量把数据收集出来,我们常用channel类型,此时channel的功能就是一个buffer,多个生产者把数据写入到channel中,消费者从channel中读取数据,但是Go的channel并没有提供批量读取的方法,我们需要自己实现一个。ithub.com/smallnest/exp/chanx 库当然我已经实现了一个batch库,你可以直接拿来用,本文主要介绍它的功能、使用方法以及设计原理和考量:github.com/smallnest/exp/chanx。我们可以使用这个库的Batch方法来批量读取数据,它的定义如下:1funcBatch[T any](ctx context.Context, ch <-chanT, batchSizeint, fnfunc([]T))第一个参数是Context,可以让调用者主动取消或者超时控制第二个参数是channel,我们从这个channel中读取数据。channel可以在外部被关闭第三个参数是批处理的大小,也就是我们从channel中读取一批数据的最大量第四个参数是一个函数,我们把从channel中读取的一批数据传递给这个函数,由这个函数来处理这批数据举一个例子:123456789101112131

...继续阅读

(71)

发表于

2023-12-20 08:49:04

批量文件重命名 – 无需下载软件,居然可以在「浏览器里」批量重命名文件。

发表于

2023-12-20 03:34:19

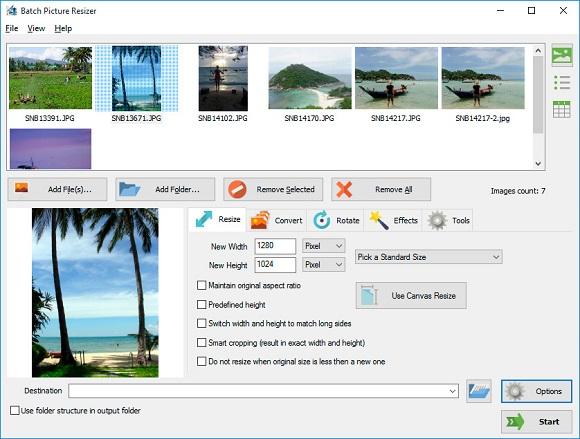

Batch Picture Resizer – 图片大小批量修改[Windows][$39.99→0]

发表于

2023-12-18 08:40:19

Imaget - 图片一键下载工具[Windows、macOS]

Imaget 是一款可以从任何网站或社交媒体平台一次性下载所有图片的工具,支持从 Instagram、Pinterest、Google 等任何网站一键批量以原始质量下载图片、图库和 gif,还可以轻松创建相册,实现有序收藏。本次赠送授权为 6 个月。

...继续阅读

(32)

发表于

2023-12-15 13:42:42

FreeBuf早报 | 国内企业遭高级勒索团伙批量投毒;《金刚狼》相关数据疑被泄露

全球动态1. 曾注册超 7.5 亿个欺诈账户!微软捣毁越南知名网络犯罪团伙Storm-1152 是一家网络犯罪即服务提供商,也是欺诈性 Outlook 账户以及其他非法 "产品 "的头号销售商,其供应的非法 "产品 "包括绕过微软验证码挑战并注册更多欺诈性微软电子邮件账户的验证码自动解决等多种服务。【外刊-

...继续阅读

(39)

发表于

2023-12-09 15:54:17

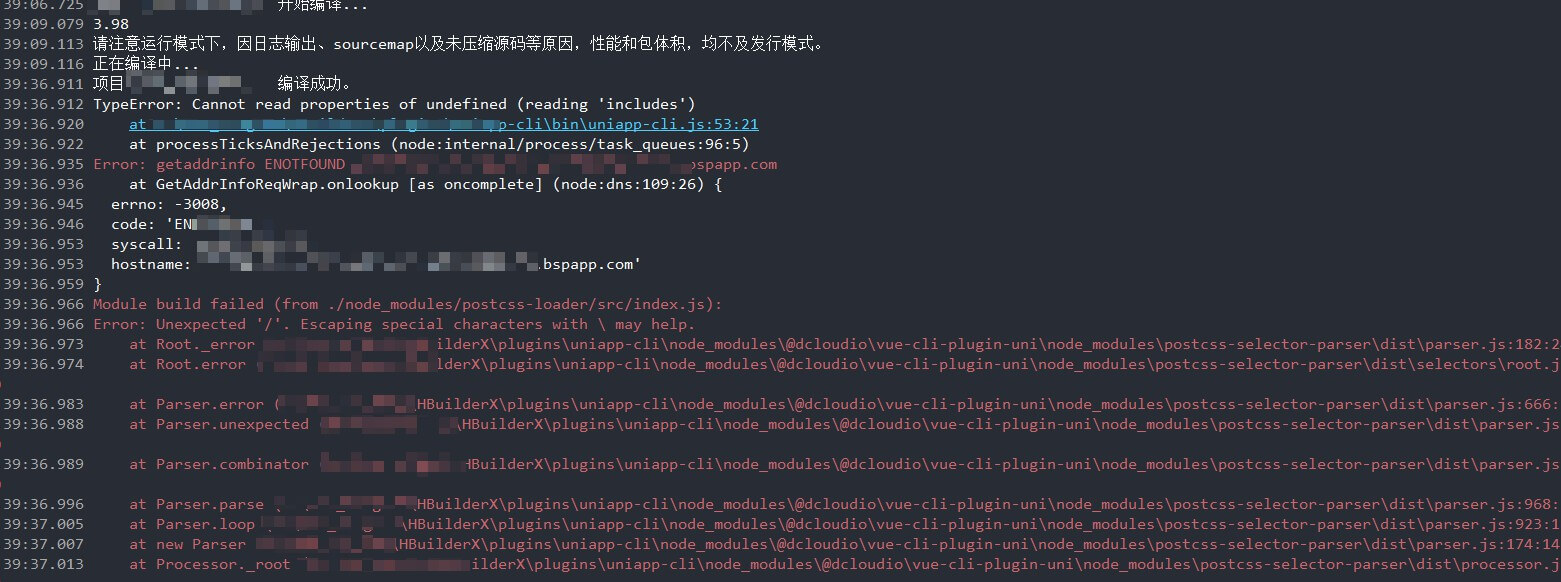

就因为 */ 被折腾了 2 个小时

发表于

2023-12-05 05:29:22

Python 批量获取 gitlab 项目代码

现在越来越多的公司采用 gitlab 来管理代码。gitlab有个问题,免费版不支持全局代码搜索,这很麻烦。如果把代码全部clone到本地就可以方便的进行各种搜索了。

...继续阅读

(52)

发表于

2023-11-24 13:53:28

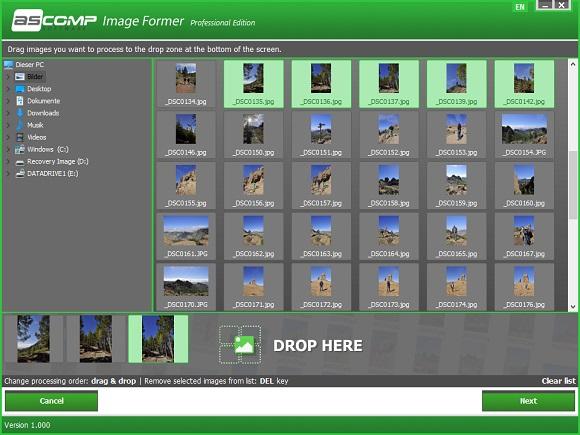

Image Former Professional - 图片批量处理工具[Windows][$19.9→0]

发表于

2023-11-23 15:02:06

A股三大指数集体收涨,高位股批量跌停

36氪获悉,A股三大指数集体收涨,沪指涨0.6%,深成指涨0.78%,创业板指涨0.58%;高位股批量跌停,三柏硕、传智教育、亚威股份等十余股跌停;汽车产业链掀涨停潮,远东传动、华阳集团等多股涨停,长安汽车、东风汽车涨超6%;地产股领涨,大龙地产、金科股份涨停;传媒、贵金属板块跌幅居前,百纳千成、佳云科技跌超10%,唐德影视、省广集团跌超8%;北向资金净买入超50亿元。

...继续阅读

(13)

发表于

2023-11-23 10:36:03

南山铝业:公司是国产大飞机C919项目的航空板主要供应商之一

36氪获悉,南山铝业在互动平台表示,作为国内首家实现批量化生产四门两盖铝板的生产商,公司技术优势明显、认证产品储备丰富、产品认证速度快,与多家知名汽车制造商建立长期合作关系,树立起良好的品牌声誉和市场地位,随着产品产能的不断增长和释放,客户群体数量及市场占比将会得到进一步提升。此外,公司是国产大飞机C919项目的航空板主要供应商之一。

...继续阅读

(21)

发表于

2023-11-23 02:49:22

Imaget - 图片一键下载工具[Windows、macOS]

Imaget 是一款可以从任何网站或社交媒体平台一次性下载所有图片的工具,支持从 Instagram、Pinterest、Google 等任何网站一键批量以原始质量下载图片、图库和 gif,还可以轻松创建相册,实现有序收藏。本次赠送授权为 3 个月。

...继续阅读

(39)

发表于

2023-11-13 15:31:57

捷佳伟创:已实现表金属0.5ppbw以上等级的电子级硅料批量出货

36氪获悉,捷佳伟创在互动平台上称,公司子公司常州捷佳创精密机械有限公司此次电子级硅芯硅料清洗设备研发的过程中,研发人员攻坚克难,突破了诸多关键技术,为设备的成功研发奠定了坚实的技术基础,并成为国内率先达到电子级标准的硅芯硅料清洗设备研发生产厂商。目前公司已实现表金属0.5ppbw以上等级的电子级硅料批量出货,2024第一季度将推出0.1ppbw以下的产品。

...继续阅读

(20)

发表于

2023-11-13 08:47:07

Batch PDF Encryptor PRO - 批量 PDF 文档加密工具[Windows]

Batch PDF Encryptor PRO 是一款可以批量为 PDF 文档进行加密的工具,它可以对文档的编辑、打印、访问进行限制,你可以批量设置访问密码,也可以单独为 PDF 文档设置唯一的密码。下载地址:https://www.pdfzilla.com/down/batchpdfencryptor_promo.exe激活码:8F-JK9482-ZMKL1-BBPED 来自反斗限免

...继续阅读

(43)

发表于

2023-10-28 09:21:06

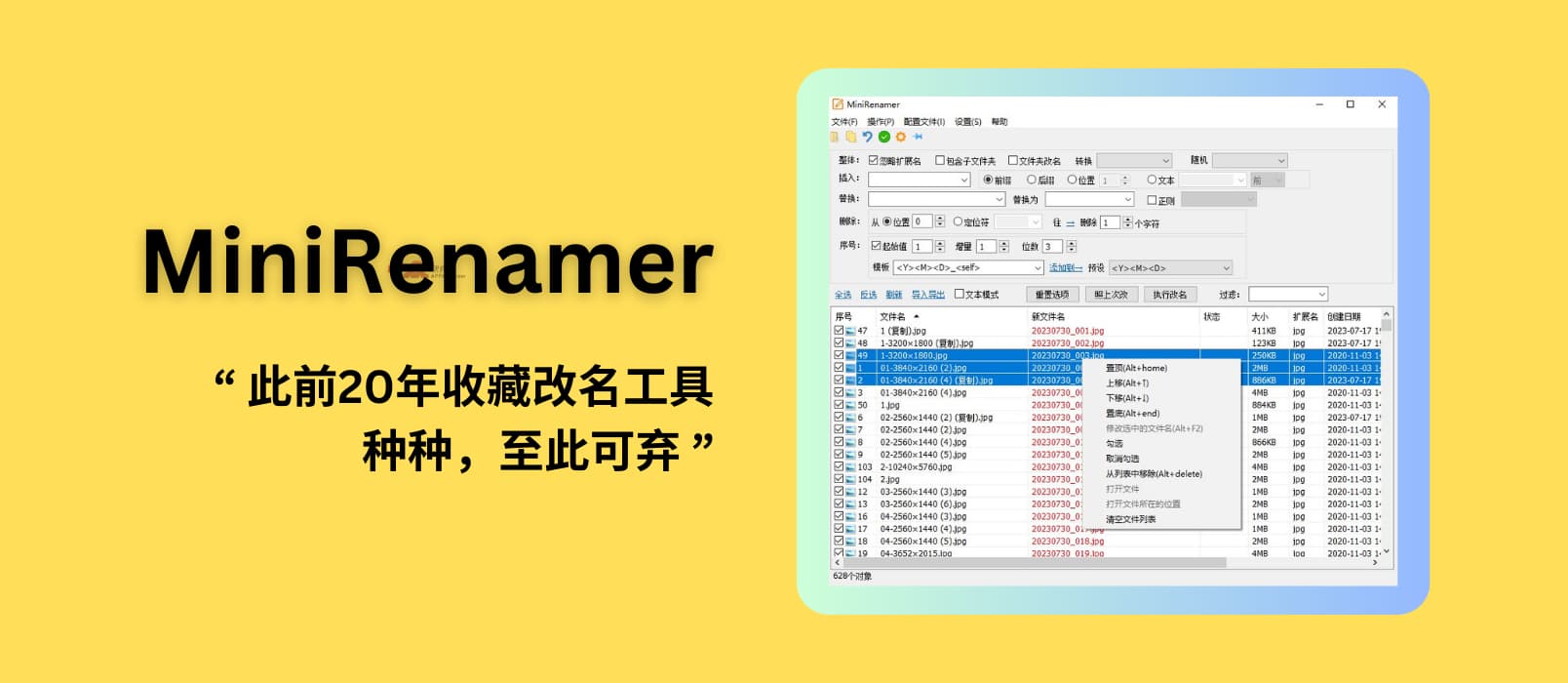

MiniRenamer – 支持实时预览的批量重命名工具,用户:此前20年收藏改名工具种种,至此可弃[Win]

发表于

2023-10-27 08:23:48

“二套转首套”,存量房贷利率批量下调

“已经查到购房贷款利率降了,月供少了4900多元,压力确实减轻不少。”广东地区的赵先生表示,10月初他向工行提交了“二套转首套”的申请材料,25日,他通过银行App查询到该笔贷款已调整为“二套转首套”,且利率也已下调。据了解,10月25日起,多家银行批量调整了已通过审核的“二套转首套”存量房贷利率。不少购房者房贷利率下调为最新首套房贷利率标准,利息支出有所减少。(中证网)

...继续阅读

(26)

发表于

2023-10-23 11:39:36

B端产品功能设计思路解析–批量导入

发表于

2023-10-22 15:38:59

Resize Me! Pro – 快速修改图片大小[Android][$1.49→0]

Resize Me! Pro 是一款可以让你快速进行图片大小修改的工具,除此之外你还可以对图片进行旋转、切割等操作,并且让自己选择是否保留 EXIF 信息以及照片的地理信息。你可以在应用中打开它来修改图片大小,也可以在文件浏览器中使用它。

...继续阅读

(64)

发表于

2023-10-21 01:12:15

小红书运营利器 | 使用AI批量把公众号文章转成图片

发表于

2023-10-20 15:49:23

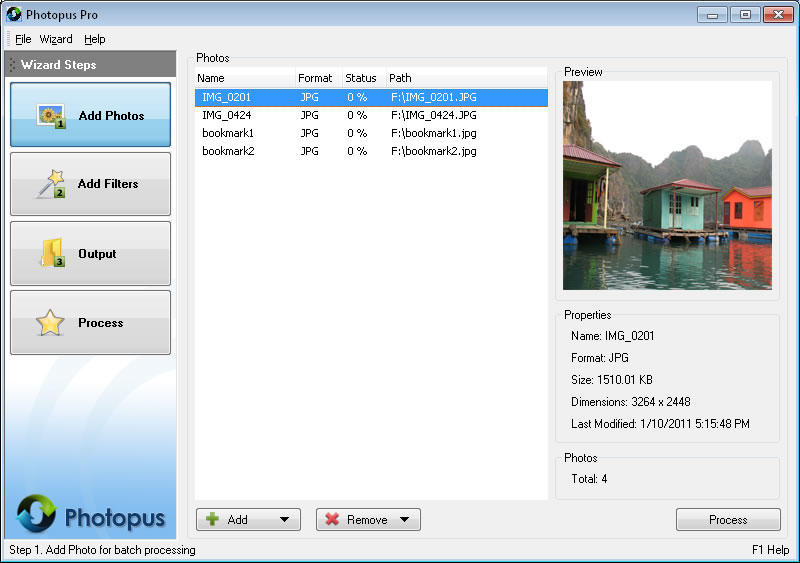

Photopus Pro – 批量图片编辑软件[Windows][$39.95→0]

发表于

2023-10-12 15:42:48

导远电子宣布将为大众全球多款车型提供高精度定位解决方案

36氪获悉,近日,导远电子宣布获得大众汽车集团旗下子公司CARIAD批量定点,将为大众集团全球多个品牌及车型提供高精度定位解决方案。导远将在此次合作中研发、交付高精度组合定位总成P-Box。

...继续阅读

(14)

发表于

2023-10-09 15:58:12

「宏德新材」获数千万元Pre-A轮融资,专注热塑性纤维增强复合材料的研发和生产 | 36氪首发

发表于

2023-10-08 14:58:13

如何批量注册海外社媒账号?

近期,我尝试批量注册各大海外社交媒体账户,完成主流平台的注册任务后,总结出一些实用经验供参考:问题处理:在注册过程中可能遭遇各类问题,如错误提示、页面无法加载或验证码未收到等。通常,这些问题的出现很可能与IP或网络环境有关,无需费时百度解决方案。基本可以确定,如果在注册的第一步就遇到问题,很可能是由风控机制引发的。推荐注册方法:使用手机(云手机或实体手机均可)搭配清洁的IP进行注册,这样的注册过程通常会相对顺畅无阻。YouTube与Gmail注册:注册YouTube账号需用到Gmail邮箱,而Gmail的注册又需要手机验证。国内手机号能接收谷歌的验证码,如果需注册多个Gmail账号,可以选择购买或利用接码网站。几个常用的接码网站:5sim.net;sms-activate.org;sms-bus.com;tiger-sms.com。接码平台是互联网的神器之一,它为我们提供了临时手机号,帮助解决了手机号验证的难题。无论是注册新账号,还是验证老账号,接码平台都能派上用场。接码平台的优势在于保护了我们的真实手机号不被滥用,同时也让我们在全球各地的网站和应用上畅通无阻地创建账户提供了可能。这几个超实用的接码平台,几乎支持市面上主流的社媒注册平台,都有几十种充值方式,包括支付宝充值。无需手机验证的平台:除Gmail外,Facebook、Instagram、TikTok、Twitter(现更名

...继续阅读

(85)

发表于

2023-10-02 02:27:29

dos 批量ren 无后缀名的文件-CarlZeng

批量修改文件名:

同样在命令提示符下输入for /r . %a in (*.aa) do rename %a *.bb

需要使用: for %a in (*.*) do ren "%a" "%a".html

要注意这个"%a"否则系统可能会认为你要重命名的是一个文件夹,就会报错The syntax of the command is incorrect.

...继续阅读

(53)

发表于

2023-09-26 13:34:54

德宏股份:便携式储能已实现批量供货,工商业储能正在积极推进

德宏股份近日在业绩说明会上表示,公司的储能板块业务正在积极推进,经过前期筹备和试生产,目前便携式储能已实现批量供货,工商业储能业务正在积极推进当中。(证券时报)

...继续阅读

(30)

发表于

2023-09-25 09:15:58

深耕核心部组件+自动化生产,「魔方卫星」打造高性价比卫星