发表于

2024-08-04 20:24:32

Chunking:基于大模型RAG系统中的文档分块

【引】“枯萎,无法回避,如人之生老病死;荒芜,无法接受,如碌碌无为一生。” 这是周六回乡下除草的感受。有所得,有所感,对工程技术也是如此。将大文档分割成较小的分块是一项关键而复杂的任务,对RAG系统的性能有着重大的影响。一般地,RAG系统旨在通过将基于检索的方法和基于生成的方法相结合,提高产出的质量和相关性。有多种框架提供了文档分块方法,每种方法都有自己的优点和典型用例。或许,利用主题感知的句子嵌...

...继续阅读

(46)

发表于

2024-08-02 09:46:18

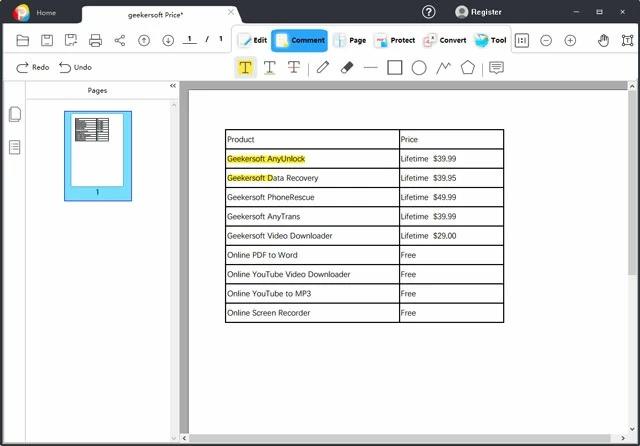

PDF Eraser Pro – PDF 文档擦除软件[Windows][$29.95→0]

PDF Eraser Pro是一款 PDF 文档擦除软件,当你发现 PDF 文档里有不想要的文字、图片或者是页面时,可以通过使用 PDF Eraser Pro 来将它们消失掉,水印什么的当然也不在话下了,同时它还可以将页面旋转。获取地址:https://www.giveawayoftheday.com/pdf-eraser-pro-2/城通网盘:https://url58.ctfile.com/f/48199458-1339262182-e40e1f?p=6995(访问密码: 6995)截止时间:2024年8月3日16时 来自反斗限免

...继续阅读

(26)

发表于

2024-08-02 02:21:58

绝了!这样做竟能让RAG准确率飙升至90%以上,简直开挂!

发表于

2024-08-02 02:19:07

产品方案整理及PRD

发表于

2024-08-02 01:59:50

谁该成为大模型成长的“养料”?

发表于

2024-08-02 01:38:32

产品需求收集及需求池文档

发表于

2024-07-31 12:58:50

一份好的策略产品需求文档

发表于

2024-07-31 06:47:35

AI时代产品经理必须懂得的技术,谈谈Rag的产生原因、基本原理与实施路径

发表于

2024-07-31 02:21:32

AI时代,产品经理日常工作如何提效30%?

发表于

2024-07-29 09:30:00

破解AI“胡说八道”,这家公司要给大模型投喂好原料|产品观察

发表于

2024-07-26 14:20:23

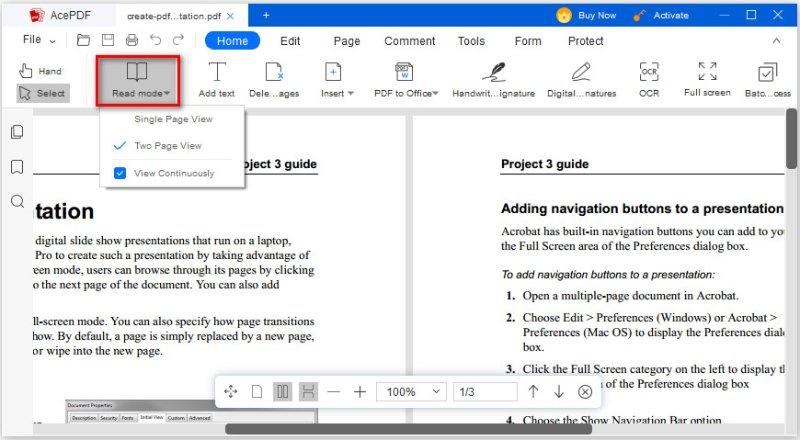

AcePDF Editor - PDF 文档编辑工具[Windows][$49.95→0]

发表于

2024-07-26 09:14:57

产品需求文档(PRD)该如何写(进阶版)

发表于

2024-07-23 09:36:53

Geekersoft Compressor - 文件压缩工具[Windows][$29.95→0]

Geekersoft Compressor是一款专业的图像、视频压缩软件,其主要功能是降低文件质量、降低文件的分辨率和位深度等,通常使用特定算法来实现压缩,对图片使用特定算法压缩并保持压缩后的图像质量,也可以将视频格式转换为压缩格式,并根据用户的需求定制视频的大小、比特率和音频参数,以取得更好的效果。获取地址:https://sharewareonsale.com/s/free-geekersoft-compressor-100-discount截止时间:2024年7月30日15时 来自反斗限免

...继续阅读

(22)

发表于

2024-07-23 07:17:00

国际化工作组发布八份备忘草案

2024年7月23日, W3C国际化工作组发布以下七份备忘草案: * 蒙古文资源(Mongolian Script Resources) * 韩文资源(Korean Script Resources) * 格鲁吉亚文资源(Georgian Script Resources) * 埃塞俄比亚文资源(Ethiopic Script Resources) * 天城文资源(Devanagari Script Resources) * 孟加拉资源(Bengali Script Resources) * 西里尔文资源(Cyrillic Script Resources)这些文档分别指向使用蒙古文、韩文、格鲁吉亚文、埃塞俄比亚文、天城文、孟加拉文和西里尔文进行文本布局和呈现的资源。目标受众包括Web标准和技术的开发者,例如HTML、CSS、移动Web、数字出版和Unicode,以及需要呈现上述这些文本的Web浏览器、电子书阅读器和其他应用程序的实施者。小组还发布了西里尔文差距分析(Cyrillic Gap Analysis)备忘草案,描述并优先考虑在Web和电子书上对西里尔文的支持差距。该文档尤其关注文本布局,检查所需的功能是否在W3C规范中得到支持,例如HTML和CSS以及与数字出版相关的功能。该文档还检查这些功能是否已在浏

...继续阅读

(83)

发表于

2024-07-22 06:17:56

产品3D文档(BRD、MRD、PRD)之间的区别和联系

发表于

2024-07-19 09:29:57

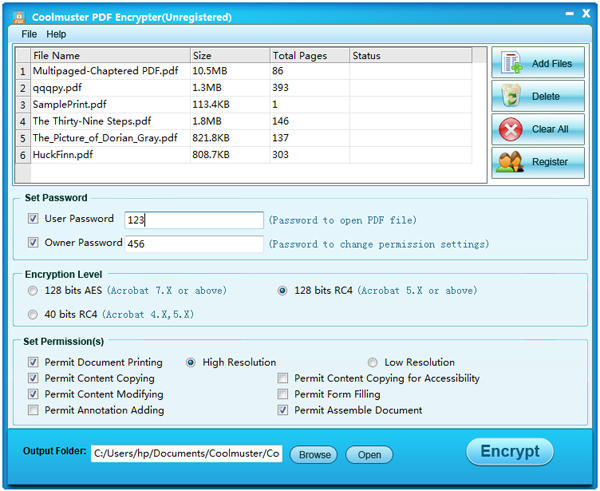

Coolmuster PDF Locker - PDF 文档保护工具[Windows][$15.95→0]

发表于

2024-07-18 13:58:14

Apowersoft LightPDF Editor - PDF 文档编辑工具[Windows][$59.99→0]

发表于

2024-07-18 09:18:00

备忘草案:协作工具无障碍用户需求

2024年7月18日,W3C可访问平台架构(APA)工作组的问题研究特别任务组(RQTF)更新协作工具无障碍用户需求(Collaboration Tools Accessibility User Requirements)备忘草案,并就此征集反馈意见。该文档涵盖了协作内容创建和开发工具的无障碍用户需求和场景。文档中的解决方案旨在影响未来无障碍指南、技术规范或协作工具和辅助技术功能的发展。这与为开发协作体验做出贡献的软件开发人员相关。参见CTAUS邮件获取关于征集反馈的更多信息。欢迎于2024年9月30日前发送反馈意见。更多内容,参见消息原文。

...继续阅读

(54)

发表于

2024-07-18 08:49:49

Just One Page PDF - 将网页生成为一页的 PDF 文件[Chrome 扩展]

要说将网页保存为 PDF 文件进行日常的使用,大多数我们都会使用浏览器自带的打印功能,但它也有个不好的地方,就是有时候当页面过长的时候,它就会自动将页面进行分页处理,导致生成的 PDF 文档是多页面的,不美观也不利于使用。最好的解决方法当然是将整个页面都打印在一个页面中,那么我们可以使用Just One Page PDF这款扩展来帮我们。Just One Page PDF是一款浏览器扩展,安装后即可使用。点击菜单栏上的图标,会弹出一个菜单,里面有很多个按钮。Window Size 这个就是生成一页 PDF 文件的,宽度则是按照你当前浏览器窗口大小来设置;Window Size (multiple pages) 则是生成多个页面,也是按照当前浏览器窗口大小,这个就跟浏览器自带打印的效果会不一样,如果你是宽屏或者将浏览器设置很宽的话,差别效果更为明显。下面还有根据 A4 纸宽度和长度来进行打印的,这个它会先进行页面的大小变化,所以如果是响应式页面的话可能打印出来的效果跟实际的效果会有所不一样。当页面加载后,你可以对 PDF 进行预览,默认页面中的所有超链接都是保留的,你可以点击 clean all link 按钮来清除所有的超链接。你可以直接选择保存,或者另存为图片,觉得体积大的话还可以先 compress it 进行压缩再保存。当前我们使用的是免费版本,单页面的话页底会有水印,多页面

...继续阅读

(58)

发表于

2024-07-18 01:32:54

用户体验五要素

发表于

2024-07-16 12:26:19

无广告,真免费!极空间部署ONLYOFFICE教程

大家好,我是熊猫,你的NAS领航员。NAS不只是存储那么简单,数码也可以是生活,关注我,给你的生活加点'技'趣!前言前段时间熊猫就ONLYOFFICE办公套件做了很是详细的介绍,但由于当时篇幅已经很长了,就没有将Docker部署的过程写进去。当时就有粉丝要求出一期极空间下部署的教程,于是就有了这篇文章。对于ONLYOFFICE本身就不作过多介绍了,作为一款开源免费的办公套件,无广告以及真免费这两点就已经很吸引人了,多的不说,跟着熊猫一起尝试在极空间部署一下。部署ONLYOFFICE套件相当大,即便是开源的社区版整个套件也来到了3.5GB的大小。同时因为办公套件运行对于内存的占用都比较大,所以个人建议NAS的内存至少要在8G或者以上。这里个人比较推荐极空间的Z4Pro以及Z423标准版,Z4Pro最低8G的内存足够使用,也可以选购16G的版本,而Z423标准版出厂16G,运行你所需要的程序或者Docker不用担心内存占满的情况。ONLYOFFICE镜像文件名称为onlyoffice/documentserver,在极空间的Dokcer界面搜索选择第一个下载,镜像标签选择latest就可以,目前社区版最新版本为8.1。当然由于目前国内镜像站纷纷关闭,所以这里我们需要替换一下镜像源。在仓库中点击设置,选择添加。库的名称随意填写,库地址填入以下这些,熊猫测试均为可用的源,且速度非常不错,用

...继续阅读

(27)

发表于

2024-07-16 05:22:00

备忘草案:拉丁文本资源和差距分析

2024年7月16日,W3C国际化工作组发布以下两份备忘草案:拉丁文本资源(Latin Script Resources):该文档指向使用拉丁文进行文本布局和呈现的资源。目标受众包括Web标准和技术(例如HTML、CSS、移动Web、数字出版和Unicode)的开发者,以及需要呈现拉丁文本的Web浏览器、电子书阅读器和其他应用程序的实现者。拉丁文差距分析(Latin Script Gap Analysis):该文档描述并优先考虑在Web和电子书上对拉丁文的支持差距。该文档尤其关注文本布局,它检查所需的功能是否在W3C规范中得到支持,例如HTML和CSS以及与数字出版相关的功能。该文档还检查这些功能是否已在浏览器和电子阅读器中得到实现。更多内容,参见消息原文。

...继续阅读

(46)

发表于

2024-07-16 01:54:54

如何写BRD(商业需求文档)

发表于

2024-07-14 05:55:09

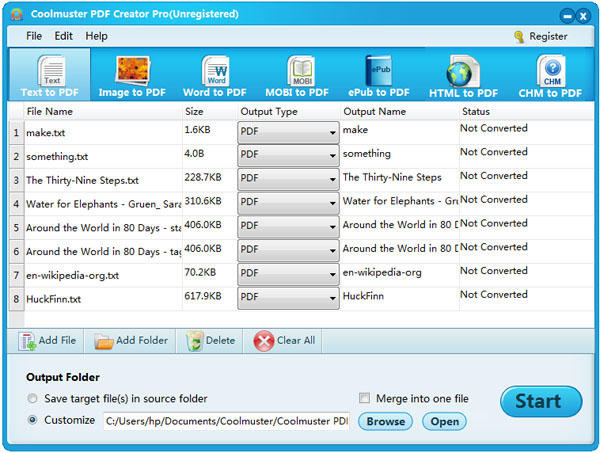

Coolmuster PDF Creator Pro – PDF 文档创建工具[Windows][$39.95→0]

发表于

2024-07-11 07:41:54

GeekerPDF - PDF 文档编辑工具[Windows][$39.99→0]

发表于

2024-07-10 03:03:59

iWatch PDF Viewer - 在 Apple Watch 上离线看 PDF 文档[iPhone、Apple Watch][内购限免]

iWatch PDF Viewer 是一款可以让你在 Apple Watch 上离线看 PDF 文档的工具,它的 iPhone 端是一个 PDF 文档创建转换工具,支持创建或者导入 PDF 文档,然后一键发送到 Apple Watch 中,在 Apple Watch 上还可以通过放大功能来阅读 PDF 文档。下载地址:运行后点击右上角升级按钮,当前 lifetime 内购价格是 0 元 来自反斗限免

...继续阅读

(31)

发表于

2024-07-09 15:14:00

WAIC 2024 已落幕:大模型再无新玩家,AGI 下半场是计算与应用

发表于

2024-07-08 11:10:17

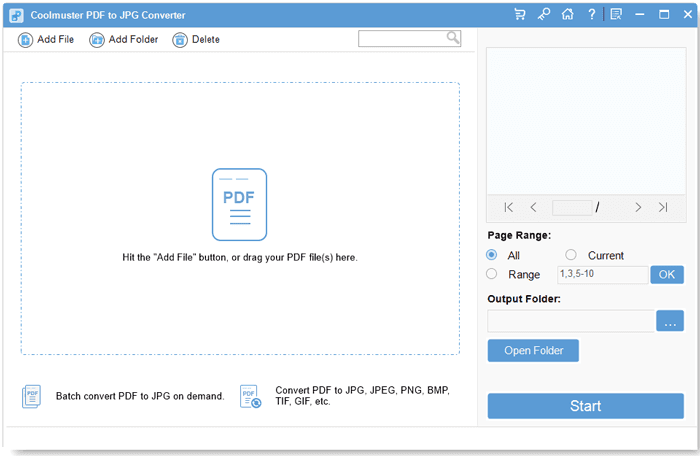

Coolmuster PDF to JPG Converter - 将 PDF 文档转换为图片[Windows][$15.95→0]

发表于

2024-07-06 13:31:57

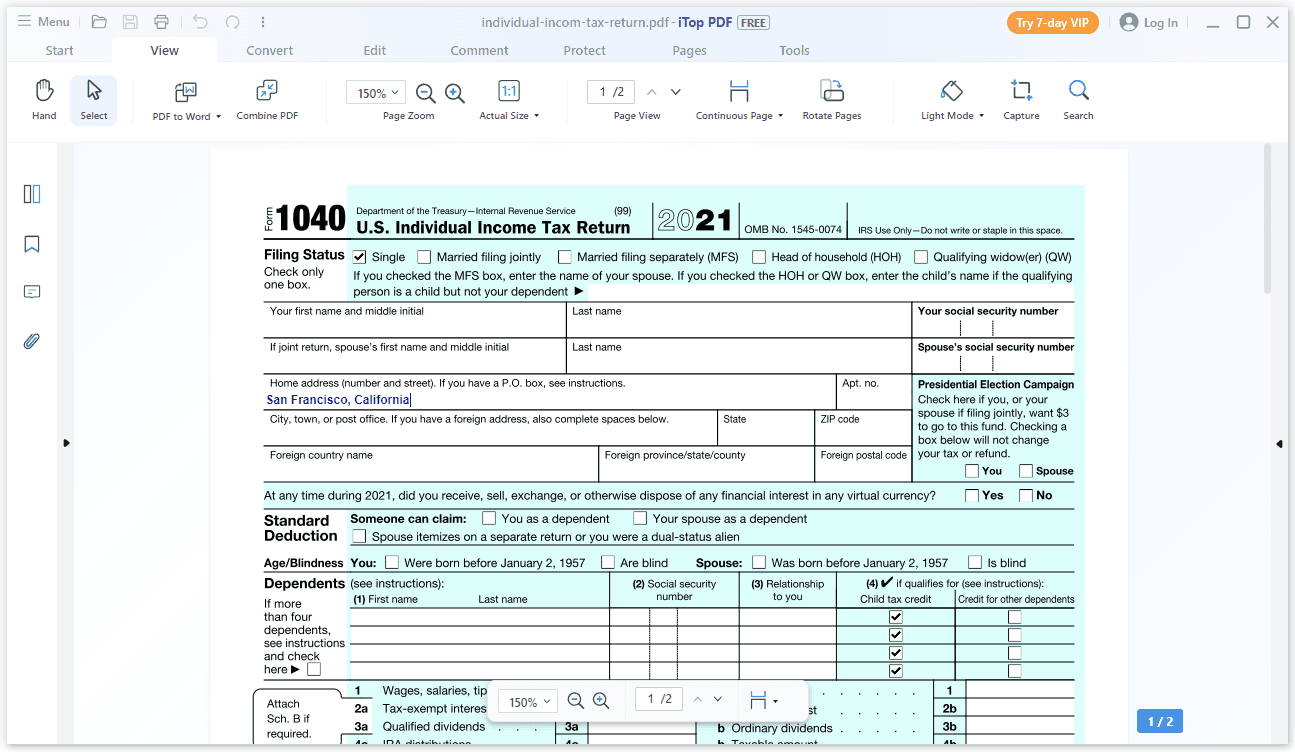

iTop PDF Pro - PDF 文档编辑工具[Windows][$49.99→0]