发表于

2025-10-23 19:00:33

中粮科技:前三季度净利润7918.60万元,同比增长724.42%

36氪获悉,中粮科技发布三季度财报。财报显示,公司第三季度营收为44.49亿元,下降14.65%;净亏损2806.06万元;前三季度营业收入为132.62亿元,同比下降12.31%;归属于上市公司股东的净利润为7918.60万元,同比增长724.42%。

...继续阅读

(17)

发表于

2025-10-23 18:54:00

阿里夸克AI眼镜24日零点开启预售 硬件配置远超全球同类产品

10月24日零点,夸克AI眼镜在夸克智能设备天猫旗舰店开启预售,京东、抖音等平台官方店铺同步开启一元预约,各平台12月初左右陆续发货。店铺预售页面显示,88VIP会员实际到手价为3699元,普通消费者为3999元。同时消费者还可以选择包含收纳盒、充电头等配件的产品套餐。预售期间所有用户还附赠3年价值900元夸克网盘SVIP会员、99元镜腿电池及配镜九折优惠等权益。夸克内部人士表示,当前价格并非产品发布时的官方售价,年底产品发布时会公布正式售价。但双11期间,因为有天猫的平台补贴,肯定是最佳购买时机。单从硬件配置来看,夸克AI眼镜S1不仅搭载双旗舰芯片高通AR1和恒玄BES2800处理器,还采用了双光机双目显示,且显示位置前后上下可调节,符合人眼视觉习惯的同时,也兼顾了不同场景下的显示舒适性。这个“隐形屏”提供了更直觉化的信息呈现方式,用户无需低头,需要的信息即可在视野中浮现。在配镜方面,区别于行业普遍采用“外挂”方式,比如用夹片或磁吸方案来搭配处方镜片,夸克AI眼镜采用定制一体贴合的配镜方案,在外观一体性、光学性能、稳定性方面具备绝对优势。在续航上,夸克AI眼镜创新性地采用了双电池加可换电设计,用户可热拔插镜腿即可完成更换主电池,并且换电期间,副电池维持续航不断电。搭配换电仓使用,真正实现了全天候续航。夸克AI眼镜外观纤薄自然,极窄的镜腿宽度、超薄的镜框厚度,视觉观感与普通眼镜无异

...继续阅读

(16)

发表于

2025-10-23 18:49:44

值得买:第三季度归母净利润75.59万元,同比增长119.62%

36氪获悉,值得买发布三季度财报。财报显示,2025年第三季度实现营业收入2.24亿元,同比下降24.42%;归属于上市公司股东的净利润75.59万元,同比增长119.62%;基本每股收益0.00元。 前三季度实现营业收入8.06亿元,同比下降20.37%;归属于上市公司股东的净利润1344.86万元,同比增长253.49%;基本每股收益0.07元。

...继续阅读

(11)

发表于

2025-10-23 18:46:12

华阳国际:与专业投资机构共同投资设立合伙企业

36氪获悉,华阳国际公告,公司以自有资金认缴出资6,600万元参与设立深圳市重投芯耀一号科技投资合伙企业(有限合伙),出资比例为10.9963%。该合伙企业认缴出资总额为60,020万元,经营范围包括信息技术咨询服务、信息咨询服务、以自有资金从事投资活动等。此次投资事项在总经理的审批权限范围内,无需提交公司董事会及股东会审议。

...继续阅读

(15)

发表于

2025-10-23 18:45:51

宜安科技:第三季度净利润为1902.73万元,同比增长10957%

36氪获悉,宜安科技发布三季度财报。财报显示,公司第三季度营收为4.42亿元,同比增长8.11%;净利润为1902.73万元,同比增长10,957.08%。前三季度营收为11.64亿元,同比下降1.75%;净利润为34.3万元,同比下降86.02%。

...继续阅读

(14)

发表于

2025-10-23 18:43:50

科氪 | 荣耀AI终端生态大会盛大启幕:“1×3×N”生态战略加速千亿级产业集群落地

发表于

2025-10-23 18:39:34

扬杰科技:终止收购贝特电子100%股权

36氪获悉,扬杰科技公告,公司收到贝特电子实际控制人、主要股东签署的《关于终止转让本人持有的东莞市贝特电子科技股份有限公司股份的通知书》,决定终止向公司转让其持有的贝特电子全部股份。公司同意上述股东终止转让股份,并决定终止收购贝特电子100%股份的全部交易。公司尚未支付股权转让款,股份尚未交割,不会导致公司产生任何经济损失,不会对公司财务状况产生不利影响。

...继续阅读

(13)

发表于

2025-10-23 18:38:36

中文在线:第三季度净利润亏损2.94亿元,下降673.14%

36氪获悉,中文在线发布三季度财报。财报显示,公司第三季度营收为4.55亿元,同比增长31.43%;净利润亏损2.94亿元,下降673.14%。前三季度营收为10.11亿元,同比增长25.12%;净利润亏损5.2亿元,下降176.64%。

...继续阅读

(17)

发表于

2025-10-23 18:37:47

晶瑞电材:公司第三季度净利润5861.50万元,同比增长938.99%

36氪获悉,晶瑞电材发布三季度财报。财报显示,公司第三季度实现营业收入4.19亿元,同比增长14.27%,净利润5861.50万元,同比增长938.99%。年初至报告期末,公司实现营业收入11.87亿元,同比增长11.92%,净利润1.28亿元,同比增长19202.65%。

...继续阅读

(23)

发表于

2025-10-23 18:37:12

阿里夸克AI眼镜24日零点开启预售

36氪获悉,阿里巴巴首款自研AI眼镜夸克AI眼镜24号零点在夸克智能设备天猫旗舰店开启预售。88VIP会员实际到手价为3699元,普通消费者为3999元。预售期间所有用户还附赠3年价值900元夸克网盘SVIP会员、99元镜腿电池及配镜九折优惠等权益。

...继续阅读

(23)

发表于

2025-10-23 18:36:24

科林电气:第三季度扣非净利润4799.29万元,同比增长1438%

36氪获悉,科林电气发布三季度财报。财报显示,公司前三季度营业收入32.16亿元,同比增长23.63%;归属于上市公司股东的净利润2.17亿元,同比增长45.90%。其中,第三季度营业收入10.72亿元,同比增长27.27%,净利润5652.32万元,同比增长705.48%,扣非净利润4799.29万元,同比增长1438.37%。业绩增长主要系本年度生产经营稳步增长,本报告期延续稳定态势,上年第三季度基数较低所致。

...继续阅读

(20)

发表于

2025-10-23 18:32:26

腾讯ima公布2.0版本,将开启任务模式内测

36氪获悉,2025年10月23日,腾讯ima open day在北京举行,会上ima公布了ima2.0版本,将于24号启动内测。ima2.0版本包括了以agent能力为基础的“任务模式”,以及知识库“AI要点”等功能。升级后的ima,将成为能理解目标、执行任务、产出结果的“共事伙伴”。

...继续阅读

(18)

发表于

2025-10-23 18:07:07

氪星晚报|Waymo将在纽瓦克机场启动人工驾驶测试;波音任命陆一鸣为中国总裁;菜鸟正式进入“小时达”时代

大公司:霸王茶姬马来西亚最大门店开业,当地门店总数突破200家36氪获悉,近日,霸王茶姬在马来西亚的最大门店于吉隆坡开业。同日,另一家旗舰店在吉隆坡商圈Mid Valley开业。伴随着这两家门店正式开业,霸王茶姬在马来西亚已开出200家门店。Waymo将在纽瓦克机场启动人工驾驶测试当地时间10月22日,Alphabet旗下无人驾驶技术公司Waymo宣布,将在美国纽瓦克机场开展配备安全员的人工驾驶测试,为未来实现该交通枢纽的自动驾驶接送服务奠定基础。Waymo在社交平台表示,正与纽约与新泽西港务局官员合作推进此项测试。小米汽车副总裁否认宣传“SOS 1秒接通”:系造谣诋毁,将追责36氪获悉,针对近期网传 “小米汽车SOS 1秒接通 不含排队时间”等相关内容,小米汽车副总裁李肖爽发文称,该内容完全失实,公司从未在发布会上或物料上有过此宣传,系采用AI技术生成、造谣诋毁小米汽车。公司已对该内容进行证据保全,并坚决追究相关责任主体的法律责任。马斯克称希望对特斯拉拥有更多投票控制权在周三的特斯拉财报电话会议上,马斯克谈到了拥有更多投票控制权的重要性,他说,由于特斯拉已经是一家上市公司,他不可能像其他科技公司创始人那样获得“超级投票权”的股票授予。马斯克说,他希望对特斯拉拥有足够的控制权,以便能够继续掌管公司。波音任命陆一鸣为中国总裁波音公司任命陆一鸣(兰登·卢米斯,Landon Loomis

...继续阅读

(20)

发表于

2025-10-23 18:00:55

Gartner:2025年AI PC全球出货量将达到7780万台

根据Gartner的数据,到2025年底,人工智能(AI)个人电脑将占全球个人电脑市场总量的31%。到2025年,人工智能个人电脑的全球出货量预计将达到7780万台。Gartner高级主管分析师Ranjit Atwal表示:“人工智能个人电脑正在重塑市场,但由于市场不确定性导致的关税和个人电脑购买暂停,它们在2025年的采用速度正在放缓。然而,用户将投资于人工智能个人电脑,以确保他们为边缘人工智能的日益整合做好准备。”Gartner分析师预测,人工智能PC出货量将达到1.43亿台,预计到2026年将占PC总市场的55%。到2029年,人工智能个人电脑将成为常态。需求偏好企业和消费者对人工智能个人电脑的选择是不同的。他们的决定主要围绕着AI PC处理器平台的选择。Gartner预测,基于ARM的笔记本电脑将在消费市场获得比商业市场更大的份额,因为应用程序兼容性的挑战被克服了。在商业领域,用户更喜欢Windows上的x86系统,预计到2025年,Windows将占人工智能商用笔记本电脑市场的71%,ARM将占24%。投资于个人电脑上的人工智能功能为了配合人工智能个人电脑的广泛应用,Gartner预计,到2026年底,40%的软件供应商将优先考虑直接在个人电脑上投资人工智能功能,高于2024年的2%。同年,多种小型语言模型(SLM)将在本地PC上运行,而2023年将为零。SLM使直接在个

...继续阅读

(19)

发表于

2025-10-23 18:00:00

PB重回「1」,所有银行股的必答题

发表于

2025-10-23 17:34:42

印奇难救千里科技

发表于

2025-10-23 17:33:52

「好想来」与鸣鸣很忙,谁都成不了蜜雪冰城

发表于

2025-10-23 17:31:17

IP生态驱动价值升级,益智教育推动积木创新|世研消费指数品牌榜Vol.78

发表于

2025-10-23 16:00:52

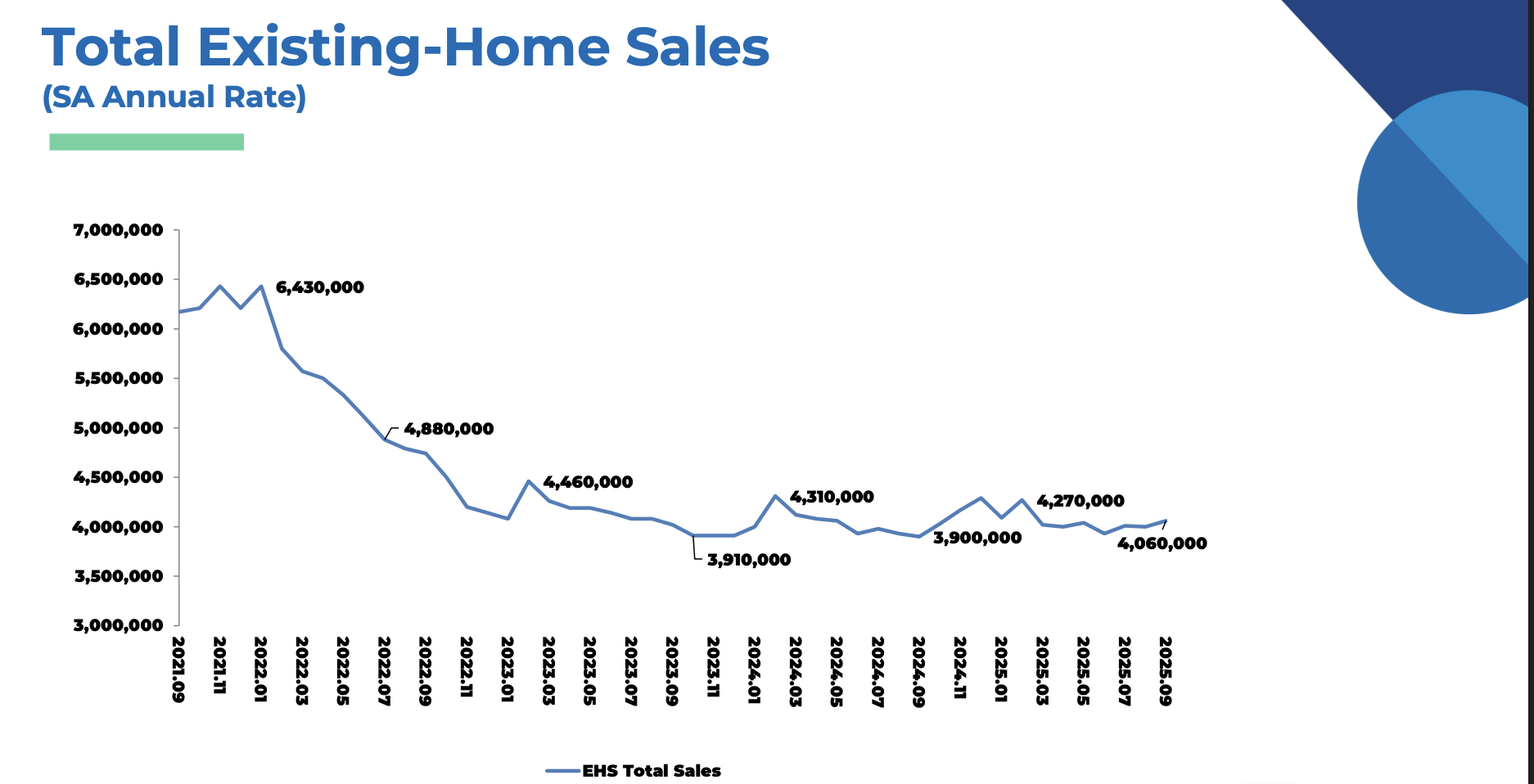

美国9月二手房销售环比上涨1.5%,库存创五年新高

发表于

2025-10-23 15:46:51

全球学者联合呼吁:暂停超级智能研发,近六成民众支持强监管

发表于

2025-10-23 15:41:23

苏博特:针对深地工程高地应力与高地热的特殊服役工况开展超高强韧等适应性材料与技术研究

36氪获悉,苏博特在互动平台表示,深地开发是指对地球深层资源的探索与利用,包括深地资源开发、深地空间利用等方面,是人类未来空间与资源利用的重要探索方向。依托重大基础设施工程材料全国重点实验室,公司对深地领域相关技术进行了前瞻性的研发布局,主要针对深地工程高地应力与高地热的特殊服役工况,开展超高强韧、超高耐久等适应性材料与技术研究,支撑深地工程安全与长寿需求。

...继续阅读

(13)

发表于

2025-10-23 15:37:34

韩国2029年起强制汽车配备防止误踩加速踏板的装置

韩国交通部周四表示,从2029年开始,韩国的新乘用车和小型商用车将被要求配备防止踏板误用的系统,以减少意外加速造成的事故。根据政府修订汽车安全标准的计划,从2029年1月开始,新制造或进口的乘用车都将强制安装此类装置。韩国政府的目标是从2030年1月开始,将适用范围扩大到3.5吨以下的货车、卡车和特种车辆。(新浪财经)

...继续阅读

(17)

发表于

2025-10-23 15:33:51

特斯拉因停车灯过亮召回63619辆Cybertruck

美国国家公路交通安全管理局(NHTSA)周四表示,特斯拉正在美国召回63619辆Cybertruck,因为停车灯太亮会降低迎面而来的司机的可见度,增加撞车风险。(新浪财经)

...继续阅读

(19)

发表于

2025-10-23 15:31:37

限时免费获取 Epic 游戏 Fear the Spotlight[Windows][¥62→0]

Fear the Spotlight 是一款氛围浓厚的第三人称恐怖冒险游戏,其中充满令人不安的谜团。与薇薇安和艾米在放学后潜入学校,设法在失控的通灵仪式中活下来、解开触控式谜题。千万注意,无论如何,不要置身于聚光灯之下……限免获取地址:https://store.epicgames.com/zh-CN/p/fear-the-spotlight-97656f限免截止时间:2025年10月30日23时 来自反斗限免

...继续阅读

(18)

发表于

2025-10-23 15:29:47

“京东汽车”名称官宣:埃安UT super

10月23日,京东联合宁德时代、广汽集团推出的“国民好车”车型名称官宣,新车命名为“埃安UT super”。据介绍,该车搭载“广汽华为云车机”技术,配备500KM续航大电池,可充可换,此外还配备“倒车哨兵”功能,倒车遇障碍物可自动刹停。(界面)

...继续阅读

(20)

发表于

2025-10-23 15:24:02

世荣兆业:公司目前未涉及其他深海经济领域业务

36氪获悉,世荣兆业在互动平台表示,本公司参股公司玉柴船舶动力股份有限公司主营生产的船用低速发动机,是海洋装备的一个重要组成部分。除此之外,公司目前未涉及其他深海经济领域业务。

...继续阅读

(17)

发表于

2025-10-23 15:19:49

字节跳动推出3D生成大模型

36氪获悉,今天,字节跳动Seed团队推出3D生成大模型——Seed3D 1.0,实现从单张图像到高质量仿真级3D模型的端到端生成。Seed3D 1.0 基于创新的Diffusion Transformer架构,通过大规模数据训练完成,可生成包括精细几何、真实纹理和基于物理渲染(PBR)材质的完整3D模型。

...继续阅读

(19)

发表于

2025-10-23 15:17:12

通用汽车承诺2028年实现“视线脱离”驾驶

通用汽车计划为美国消费者提供“脱手驾驶”功能,以及在行程中观看电影的自由。该公司于当地时间周三在纽约举办的活动中,由高管团队公布了一项全新技术计划,其中包括将于2028年推出的“视线脱离”(eyes-off)驾驶技术——即驾驶员无需持续注视路面。通用汽车同时表示,计划明年在车辆中引入对话式人工智能技术。(新浪财经)

...继续阅读

(19)

发表于

2025-10-23 15:14:12

中兵红箭:金刚石单晶产品在芯片散热应用方面正在开展研发实验,尚未实现批量化应用

36氪获悉,中兵红箭在互动平台表示,目前公司的金刚石单晶产品在芯片散热应用方面正在开展研发实验,尚未实现批量化应用。出口管制政策的变化可能会使相关产品的审批周期有所延长,短期内,部分外贸客户会提前购买公司产品,长期影响不大,公司暂无调整产品价格的计划。

...继续阅读

(22)

发表于

2025-10-23 15:10:03

国家邮政局:9月邮政行业业务收入完成1525.7亿元,同比增长6.8%

36氪获悉,国家邮政局公布2025年9月份邮政行业运行情况。9月份,邮政行业业务收入(不包括邮政储蓄银行直接营业收入)完成1525.7亿元,同比增长6.8%。其中,快递业务收入完成1273.7亿元,同比增长7.2%。9月份,邮政行业寄递业务量完成183.4亿件,同比增长11.2%。其中,快递业务量完成168.8亿件,同比增长12.7%。

...继续阅读

(17)