发表于

2025-05-30 03:19:22

普通人做自媒体博主一定要培养自己的流量思维,让爆款成为常态

发表于

2025-05-30 03:17:21

AI助手小悟问:用户说 “想要一匹更快的马”,是在骗我吗?

发表于

2025-05-30 03:13:09

穿透式管理的核心逻辑

发表于

2025-05-30 03:11:48

新手如何做一个能赚钱的视频号(保姆级教程)

发表于

2025-05-30 02:02:35

从0构建大模型知识体系(5):大模型BERT

发表于

2025-05-30 01:58:20

设计思维失效了吗? 如何做变革设计?

发表于

2025-05-30 01:56:19

家装「黑马」住范儿的启示

发表于

2025-05-30 01:18:34

泡泡玛特 vs 必要商城:走向不同命运的6大原因

发表于

2025-05-29 19:21:08

我实在没创意了,就肝了一套AI构思+出图的表情包懒人流程

发表于

2025-05-29 19:21:08

我实在没创意了,就肝了一套AI构思+出图的表情包懒人流程

发表于

2025-05-29 15:12:46

IPD流程落地:项目任务书Charter开发

发表于

2025-05-29 15:06:34

做产品如做人,产品就是人品

发表于

2025-05-29 14:59:45

B 端设计验收 2.0

发表于

2025-05-29 14:59:45

B 端设计验收 2.0

发表于

2025-05-29 14:49:37

收款认领单全解析

发表于

2025-05-29 14:49:37

收款认领单全解析

发表于

2025-05-29 14:44:00

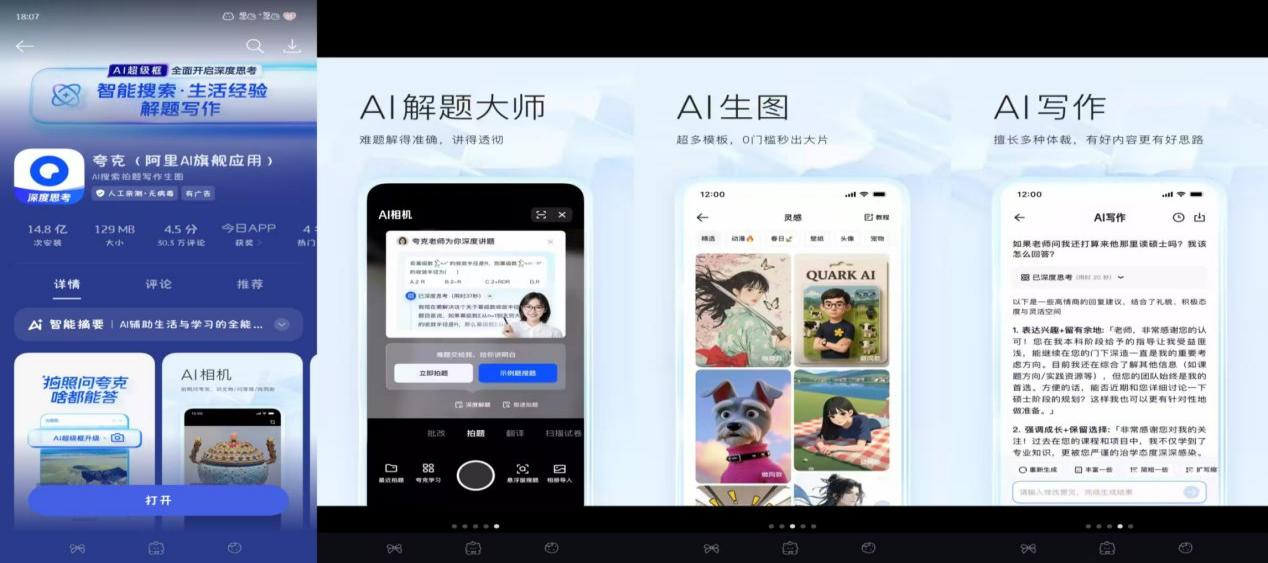

夸克浏览器 AI 进化实录:从「信息窗口」到「智能中枢」的破局之战

发表于

2025-05-29 14:44:00

夸克浏览器 AI 进化实录:从「信息窗口」到「智能中枢」的破局之战

发表于

2025-05-29 09:56:10

SaaS公司的机遇:组织智能化改造的引领者

发表于

2025-05-29 09:45:09

夸克鸿蒙版诞生记:探索技术与体验的新征程

发表于

2025-05-29 08:51:03

数据分析模型之:OGSM模型

发表于

2025-05-29 08:47:13

AI独角兽惊天骗局:印度程序员冒充AI,微软亚马逊被坑5亿,投资人36亿打水漂!

发表于

2025-05-29 08:38:50

2025年,普通教师如何一年内快速提升自己的技能,成为业内优秀人才

发表于

2025-05-29 08:23:36

融资5000万美金,用AI来给销售做培训,极度细分的赛道

发表于

2025-05-29 08:23:36

融资5000万美金,用AI来给销售做培训,极度细分的赛道

发表于

2025-05-29 08:15:13

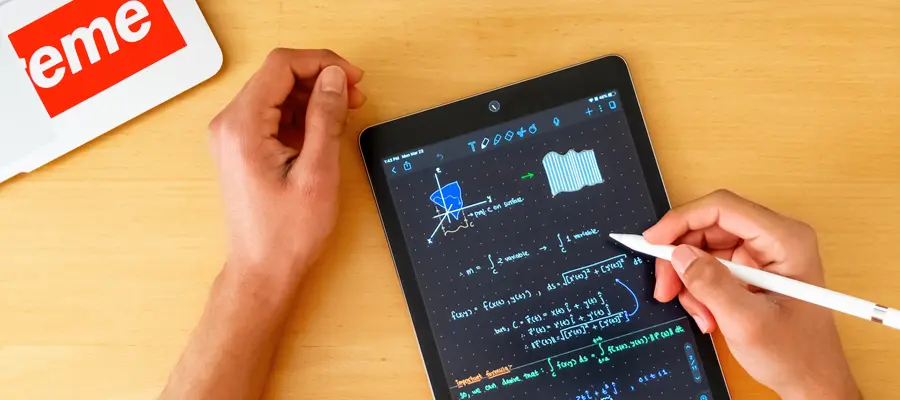

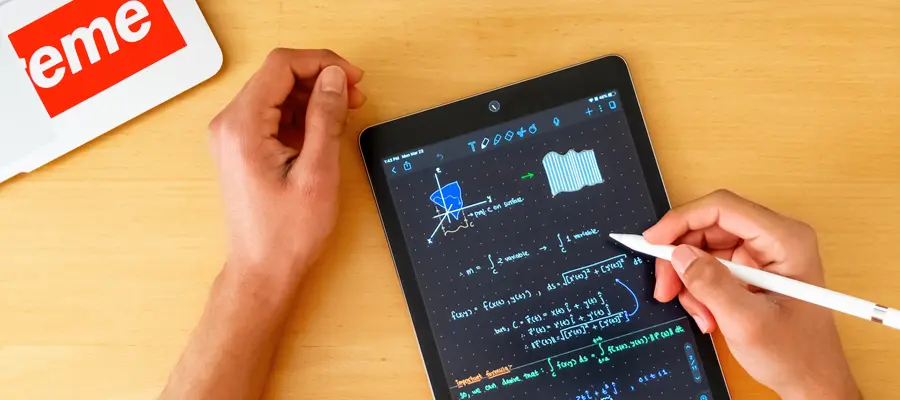

70%用户留存,估值2.5亿美金!硅谷最成功的AI笔记,到底牛在哪?

发表于

2025-05-29 08:15:13

70%用户留存,估值2.5亿美金!硅谷最成功的AI笔记,到底牛在哪?

发表于

2025-05-29 08:11:58

微信电商到底值不值得看好?

发表于

2025-05-29 08:01:57

元器件电商媒体运营01-传统与新兴

发表于

2025-05-29 07:55:58

AI 产品经理之就业调研规划