发表于

2025-05-27 05:04:57

B端设计

发表于

2025-05-27 03:47:39

谷歌Veo 3视频生成实测,强得飞起!

发表于

2025-05-27 03:39:18

AI Agent创业的“黄金时代”与“模式之困”

发表于

2025-05-27 03:32:15

国产顶级 DeepResearch 类产品,把咨询专家请回家

发表于

2025-05-27 03:28:52

拼多多单量下滑的几个原因

发表于

2025-05-27 03:19:21

从卖工具到包结果:融资600万美金,这家公司正在颠覆本地商家的运营

发表于

2025-05-27 03:16:17

小红书算法又TM变了… …

发表于

2025-05-27 03:13:15

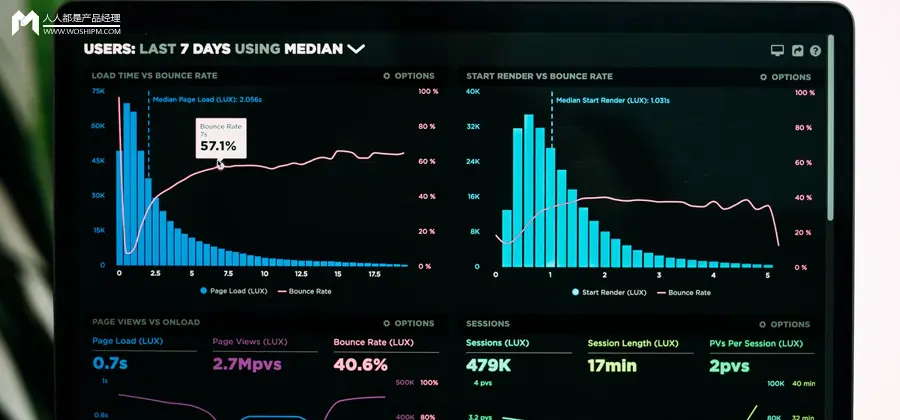

定制化BI可视化产品还能活多久?

发表于

2025-05-27 02:52:40

这3个产品面试高频问题,难倒一片人!你遇到过吗?

发表于

2025-05-26 13:20:12

从大模型工程视角看DeepSeek-V3/R1

发表于

2025-05-26 10:18:05

Claude 4 核心提示词曝光|最懂提示词的大模型公司,现在怎么写 Prompt?

发表于

2025-05-26 10:04:33

又一所谓「最强模型」Claude4发布,往超级Agent方向发展,企图降维打击Gemini

发表于

2025-05-26 10:04:22

产品最重要的一项能力

发表于

2025-05-26 09:55:02

改到半夜!一篇数据分析报告的“逆袭”

发表于

2025-05-26 09:50:20

AI生成的内容太假?试试这39条提示词,AI味爆降90%!

发表于

2025-05-26 09:48:38

物流产品经理进阶:TMS系统(运输管理)商超零售城配场景及产研合作基本原则

发表于

2025-05-26 09:39:37

普通人开网店难在哪?AI这样帮我跑通了全过程

发表于

2025-05-26 09:36:44

微信【扫一扫】背后隐藏的秘密

发表于

2025-05-26 09:31:45

拆解 | A股、港股、美股:证券账户、托管体系差异(一)

发表于

2025-05-26 09:20:48

折磨我多年的PPT,终于被AI搞定了

发表于

2025-05-26 09:09:44

用Cherry替代Manus,AI调用多个MCP在本地处理Excel生成可视化报告文件

发表于

2025-05-26 09:02:54

多邻国,因AI二次腾飞

发表于

2025-05-26 08:55:51

用AI赋能奢侈品牌:口红篇!(这些提示词很贵,请收好)

发表于

2025-05-26 08:54:32

流量生意中的三种角色

发表于

2025-05-26 08:52:02

周末带娃悟出的产品思维:每个孩子都是 “用户体验” 的考官

发表于

2025-05-26 08:50:32

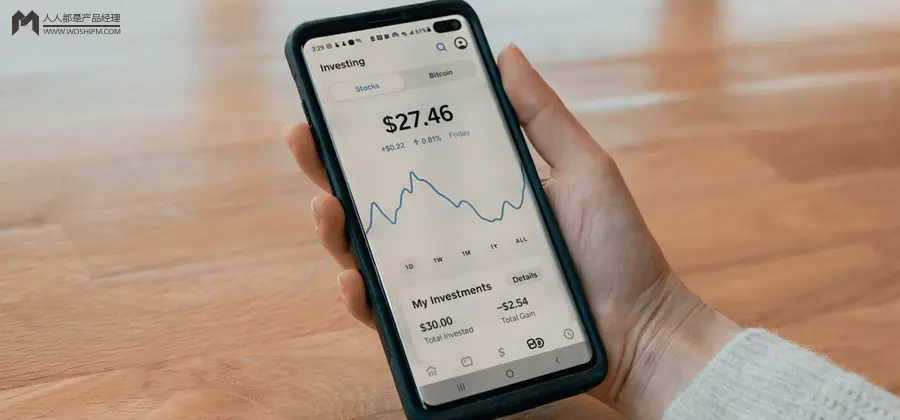

产品思维下的财富决策模型:当1000万成为人生MVP

发表于

2025-05-26 08:49:25

6200字长文:潮玩盲盒走过的四个时代

发表于

2025-05-26 08:30:51

放下你的精英视角,一起来看看“万物平权”后的财富需求是什么

发表于

2025-05-26 08:26:00

纳米AI搜索能接得住周鸿祎的流量么?

发表于

2025-05-26 08:17:38

2025生死倒计时:产品经理如何借政策东风实现数字化营销300%效能爆发